英伟达光场虚拟现实技术让用户拥有更自然的景深

拥有更自然的景深,无“晕船”反应。

在去年11月,YiVian报道了英伟达和斯坦福大学建立合作关系,使用一种光场立体镜共同研发下一代虚拟现实头显,让佩戴者在虚拟环境中获得一种更自然的景深。

本周在南加州举行的Virtual Reality LA 2016上,通过连接到一台配置了Maxwell GPU的台式机,该公司演示了其光场虚拟现实头显原型机的改进版。英伟达用来实时运算光场图像的计算架构是以用于GPU的CUDA并行编程语言为基础。

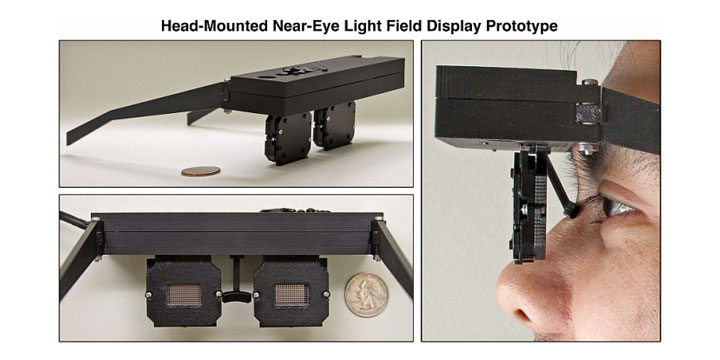

英伟达光场立体镜原型机

如今有了虚拟现实头显,用户更多时候是在看显示器而不是真实的图像。长时间以来会导致眼睛过度疲劳,佩戴者疲劳,以及最普遍的晕动症。

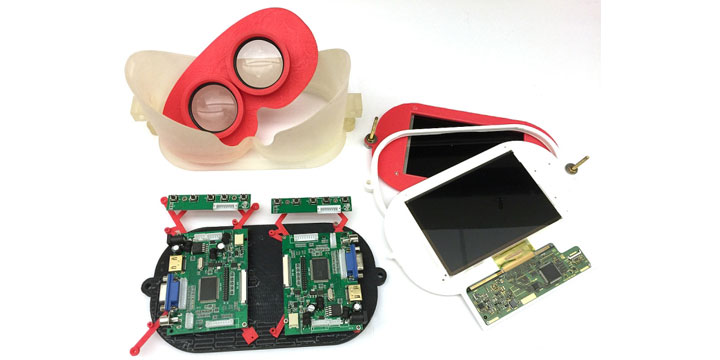

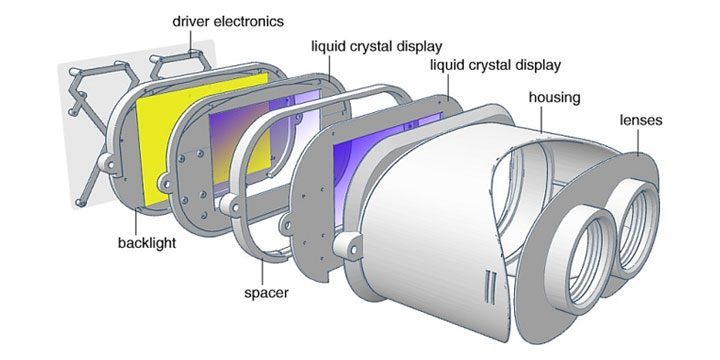

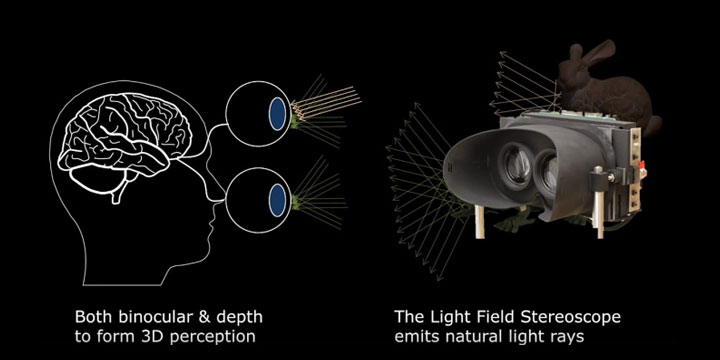

英伟达光场立体头显原理图

但是英伟达和斯坦福大学的合作项目似乎把这一技术进展到了下一个阶段,他们这款虚拟现实头显设计几乎不会出现晕动症副作用。“光场立体镜”原型机套装用了两个间隔5毫米相连的LCD面板做成的分层显示器。它们被眼镜盒后端的背光板和靠近用户眼镜的两个圆形观看镜片夹在了中间。

“我们感知自然界的方式比立体镜要复杂得多,”斯坦福大学电气工程的一位助理教授Gordon Wetzstein在一次采访中说道。“我们的眼睛能以不同的距离聚焦。即使是单眼也能看到3D图像。它通过聚焦眼球的视线来实现。”

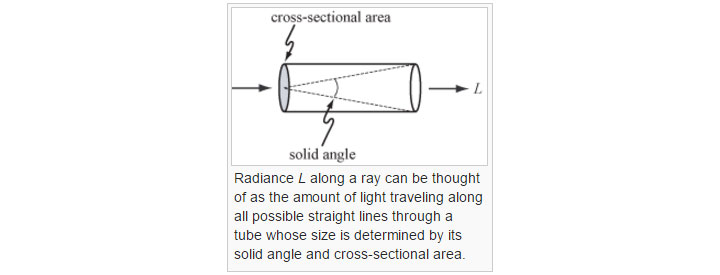

维基百科——用“L”测量的一种光场射线。

斯坦福大学和英伟达合作的这款原型机佩戴套装为双眼创造出一种自然的景深,并把它和一种从略微不同的角度在每只眼睛呈现图像的立体技术相结合。在SIGGRAPH 2013大会上,英伟达用索尼安装在一个类似于镜框的一对ECX332A OLED微显示器展示了一台早期光场显示器原型机。每个面板大小为15.36mm x 8.64mm (0.60 x 0.34 英寸),大约相当于每毫米83像素。每个显示器的分辨率为1024x720,拥有24位彩色像素以及97%的NTSC色域,亮度200 cd/m2,还有0.01秒的超低响应时间。

英伟达头戴近眼式光场显示器原型机(2013年11月)

首先,一个微透镜阵列把每个图像分成单独的光线,类似于最近推出的Lytro ILLUM全光镜头相机。该阵列在给定场景中捕获光照强度之类的信息以及光线在空间内传播的方向。最终成果就是,每个图像中捕获的景深距离显得更加立体,让眼睛看到的虚拟环境更加“自然”同时最大限度减小晕动症。

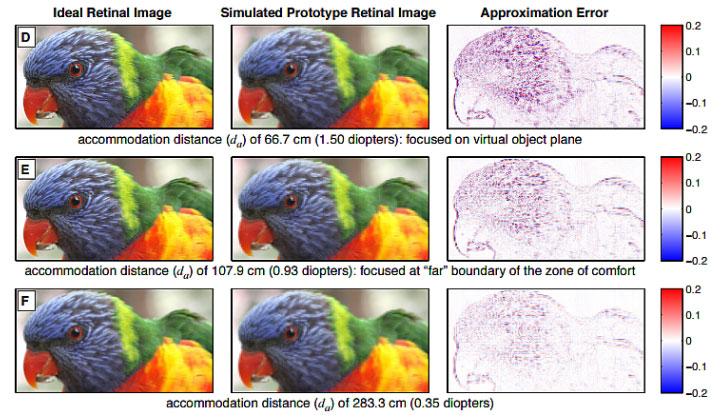

斯坦福大学在SIGGRAPH 2015大会的展示

或许光场虚拟现实最令人着迷的地方在于它可以让佩戴者的眼镜更自然地在焦点提示做出反应并休息。这就减轻了用眼疲劳而且更自然地模拟了我们在现实生活中感知世界的方式。

早在2013年11月,英伟达的研究人员Douglas Lanman博士和David Luebke博士就发表了一篇论文,介绍了公司配上头部跟踪的近眼式光场显示器原型机,所以用户就能在虚拟环境中看见自己的手。

英伟达的光场研究

他们的结论是,目前的消费者虚拟现实头显呈现出两大局限性——首先位于观众视野周围的显示器视场太窄,其次是这些头显外形笨重而且头带太紧。英伟达希望用这种微镜片显示系统改变这些限制,同时也实现了一种更宽广的视场,而且为用户提供更小型的眼镜设备,实现一种更舒适的观看体验。

光场虚拟现实技术预计会在三到五年后普遍应用到虚拟现实头显中。

[VIA fudzilla]