牛津大学与苏黎世联邦理工联合开发DNF-Avatar 实现67FPS实时角色重照明

可在大约40分钟内仅使用手机录制的视频创建基于高斯飞溅的化身

(映维网Nweon 2025年07月28日)逼真的化身对于虚拟现实和增强现实等沉浸式应用至关重要,可以在训练模拟、远程医疗和虚拟协作等领域实现逼真的交互。虚拟化身弥合了物理世界和数字世界之间的鸿沟,可通过逼真的人类表现改善用户体验。然而,现有的虚拟化身创建技术面临着重大挑战,包括成本高、创建时间长以及虚拟应用程序中的实用性有限。手动方法,如MetaHuman,则需要大量的时间和专业知识,而自动方法,如基于NeRF的管道,通常缺乏效率和细节的面部表情保真度,并且无法以足够的速度呈现实时应用。

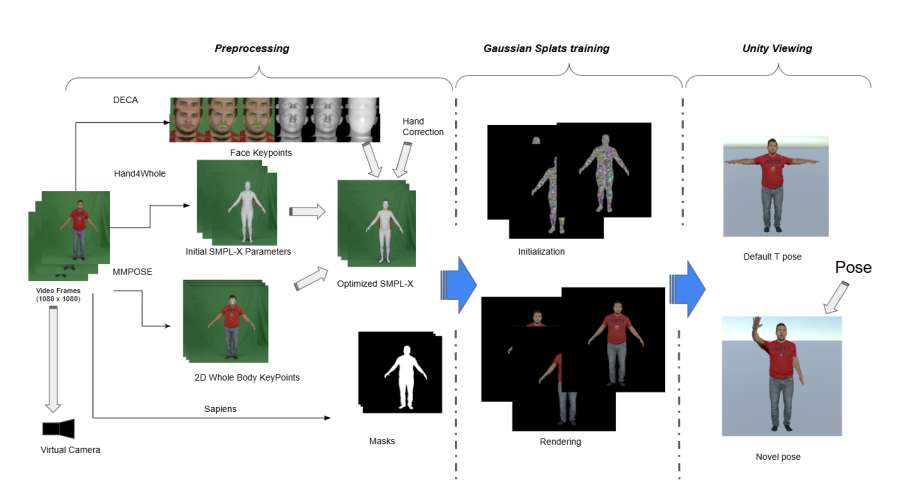

在一项研究中,通过纳入一系列的尖端现代技术,美国范德比尔特大学引入了一个端到端的3DGS化身创建管道,并可在大约40分钟内仅使用手机录制的视频创建基于高斯飞溅的化身。管道包含两大创新:采用改进型高斯飞溅算法配合定制化预处理模块,支持”非受控环境”的用户单目视频捕获,并实现精细化面部表情重建并嵌入全骨骼绑定角色模型。

另外,团队提供了一个Unity集成的高斯飞溅化身编辑器,为VR/AR应用程序开发提供了一个用户友好的环境。实验结果验证了预处理管道在标准化3DGS训练自定义数据方面的有效性,并展示了Unity中高斯化身的多功能性,突出了所提出方法的可扩展性和实用性。

......(全文 2472 字,剩余 1979 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限