FlowR突破3D重建瓶颈:稀疏视图生成高质量VR场景

3D重建

(映维网Nweon 2025年07月16日)3D高斯飞溅可以在实时帧率下实现高质量的新颖视图合成(NVS)。但当我们偏离训练视图时,它的质量就会急剧下降。所以需要密集捕获来匹配特定应用的高质量期望,例如虚拟现实。然而,如此密集的捕获非常费力和昂贵。业界已经探索了使用2D生成模型通过蒸馏或生成额外的训练视图来减轻这一要求。但它们通常仅以少数参考输入视图为条件,因此不能充分利用可用的3D信息,从而导致不一致的生成结果和重建伪影。

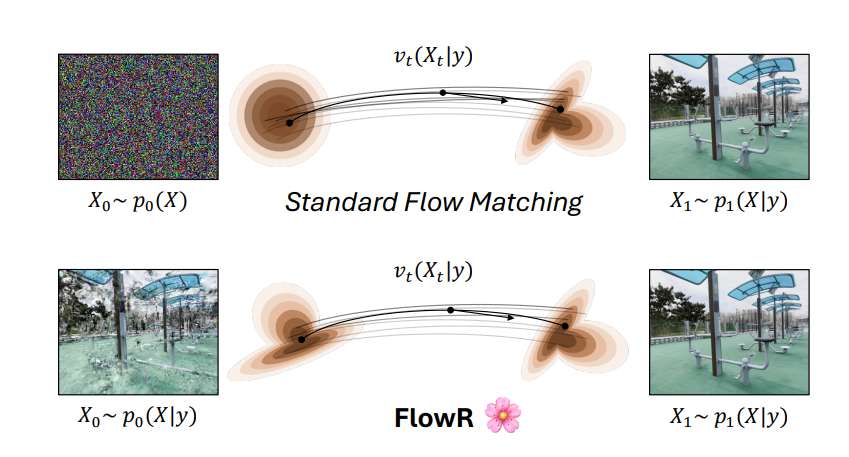

为了解决这个问题,苏黎世联邦理工学院,Meta和卡内基梅隆大学团队提出了一个多视图流匹配(flow matching)模型。它学习一个流,将可能是稀疏重建的新视图渲染结果与期望的密集重建渲染结果连接起来。

这使得可以用新生成的视图来增强场景采集,从而提高重建质量。模型是在一个360万图像对的新数据集训练,可以在一张H100 GPU以540 × 960分辨率(91K令牌)处理多达45个视图。管道在稀疏和密集视图场景下不断改进NVS,从而在多个广泛使用的NVS基准测试中获得比以前更高质量的重建。

......(全文 1424 字,剩余 1041 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限