纽约大学与哥伦比亚大学联合研发超表面神经深度成像系统Nano-3D

一种基于超表面的神经深度成像解决方案

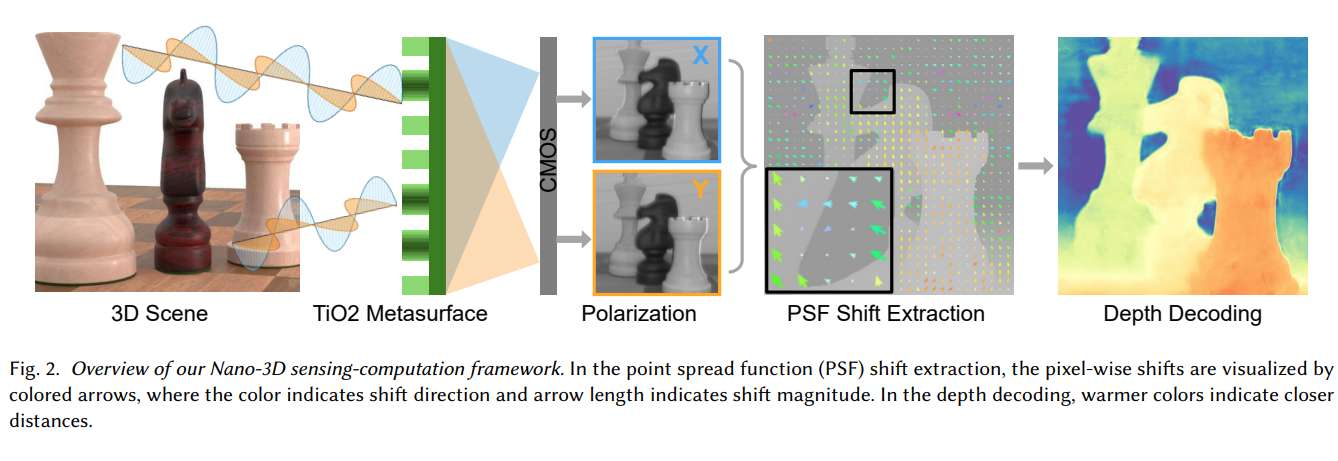

(映维网Nweon 2025年07月02日)深度成像是虚拟现实/增强现实等广泛应用的基础组成。传统而言,深度摄像头依赖于飞行时间传感器或多镜头系统来实现物理深度测量。然而,它们经常面临笨重的形状参数和不精确近似之间的权衡,限制了对空间受限场景的适用性。受纳米光学新进展的启发,纽约大学和哥伦比亚大学团队提出了Nano-3D,一种基于超表面的神经深度成像解决方案。

Nano-3D将定制的700 nm厚的TiO2超表面与多模块深度神经网络集成在一起,从单眼超表面偏振图像中提取精确的度量深度信息。团队通过模拟实验和物理实验证明了所提出方案的有效性,并希望通过新颖的计算方法来将未来的图形系统与新兴的纳米材料技术连接起来。

从物理环境中准确捕获度量深度信息是一系列应用的基本要求,例如虚拟现实和增强现实。然而,传统的2D摄像头配备了平面光电传感器,如互补金属氧化物半导体(CMOS),在记录过程中不能保留深度信息。所以,深度传感通常依赖于精度较低的飞行时间传感器,或会导致笨重设计的多镜头光学。

......(全文 1563 字,剩余 1154 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限