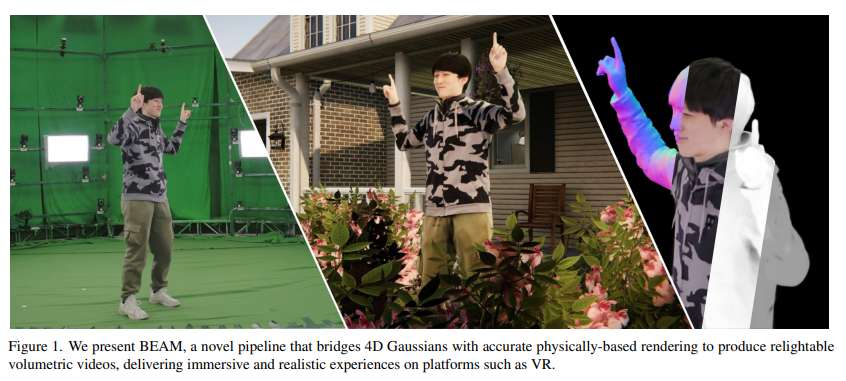

4D高斯+物理渲染实现可调光体三维视频,提升逼真视觉效果

在不同的照明条件下提供逼真、逼真的视觉效果

(映维网Nweon 2025年06月11日)体三维视频通过捕获动态3D场景实现身临其境的体验,从而支持虚拟现实等各种应用。然而,传统的方法在固定的照明条件下挣扎,而神经方法在效率、质量或可照明场景的适应性方面面临权衡。为了解决所述限制,上海科技大学,NeuDim和DGene团队提出了BEAM。

这个新颖的管道将4D高斯表示与基于物理的渲染(PBR)连接起来,从多视图RGB素材中生成高质量,可调光的体三维视频。BEAM通过一系列基于高斯的技术恢复详细的几何形状和PBR属性。它首先将基于高斯的性能跟踪与几何感知光栅化结合在一个coarse-to-fine优化框架中,以恢复空间和时间一致的几何形状。

团队通过逐步整合PBR属性进一步增强高斯属性,并利用多视图条件扩散模型生成粗糙度,然后使用2D到3D策略导出AO和基色,并结合定制的基高斯光追器进行有效的可见性计算。一旦恢复,动态的,可照明的资产无缝集成到传统的CG管道中,支持延迟着色的实时渲染和光线追踪的离线渲染。

......(全文 2200 字,剩余 1817 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限