港科大轻量级Transformer模型实现VR晕动症93%高精度实时预测

晕动症预测

(映维网Nweon 2025年05月15日)晕动症是沉浸式虚拟现实体验广泛普及的一个重大障碍,因为它会极大地破坏用户的参与度和舒适度。研究表明,晕动症可以在头部和眼动追踪数据以及其他生理数据中得到显著反映。

尽管应用了CNN和LSTM等深度学习技术,但模型往往难以捕获多个数据模式之间的复杂交互,缺乏实时推理能力,限制了它们的实际应用。

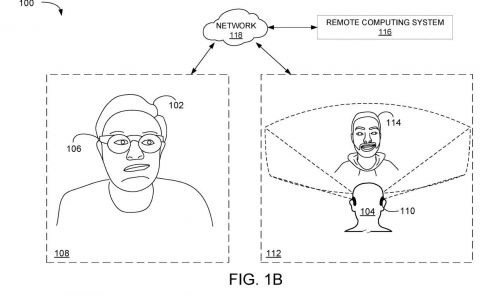

为了解决这一差距,香港科技大学(广州)团队提出了一种轻量级模型,利用基于transformer的编码器来处理生物信号特征,并通过PP-TSN网络来提取视频特征。然后,通过跨模态融合模块集成功能,创建一个视频感知生物信号表示,支持基于视觉和生物信号输入的晕动症预测。

模型经过轻量级框架的训练,在包含眼动和头部追踪数据、生理数据和VR视频的公共数据集进行了验证,并在晕动症预测方面展示了最先进的性能,仅使用VR视频输入就实现了93.13%的高精度。相关发现表明,所提出方法不仅能够有效、实时地预测晕动症,而且解决了VR环境中长期存在的模态交互问题。

......(全文 2008 字,剩余 1620 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限