西交大提出DynamicAvatars框架:高斯飞溅+LLM驱动VR虚拟人实时定制

DynamicAvatars

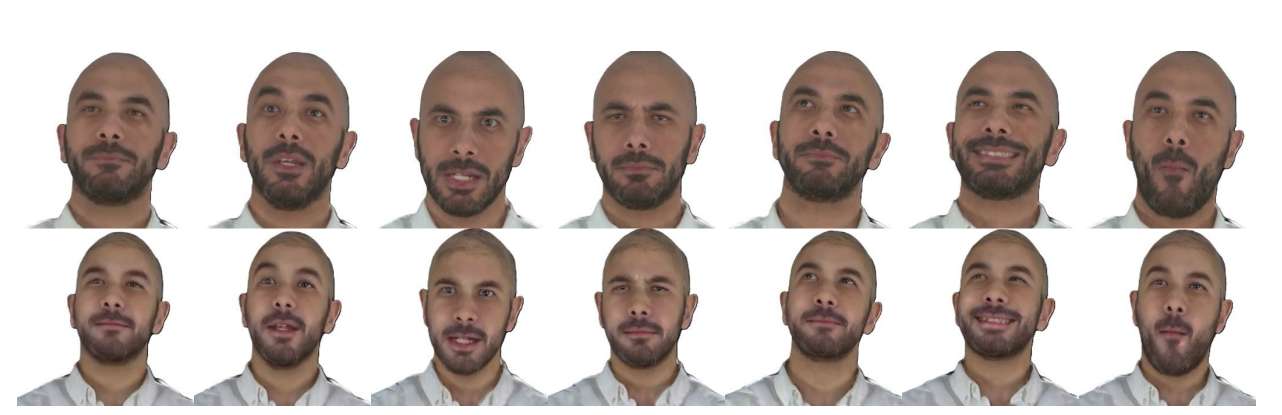

(映维网Nweon 2025年05月12日)动态Avatar的生成和编辑是虚拟现实等领域中的关键任务。然而,现有的方法经常遭受面部扭曲,头部运动不准确和有限的细粒度编辑能力的影响。为了解决所述挑战,西安交通大学团队提出了DynamicAvatars。

这个动态模型可以从视频剪辑和与面部位置和表情相关的参数中生成逼真的移动3D Avatar。所述方法通过一种基于提示的编辑模型实现精确的编辑,将用户提供的提示与来自大型语言模型的指导参数集成在一起。

为了实现这一目标,研究人员提出了一个基于高斯飞溅的双追踪框架,并引入了一个快速预处理模块来提高编辑稳定性。通过结合专门的GAN算法并将其连接到我们的控制模块,可以从大型语言模型生成精确的指导参数。另外,他们开发了一种动态编辑策略,选择性地利用特定的训练数据集来提高效率。

......(全文 1738 字,剩余 1426 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限