4DGS-Wild:单目视频动态场景的不确定性感知高斯泼溅重建

的4D Gaussian Splatting

(映维网Nweon 2025年04月22日)动态场景的新视图合成在增强现实和虚拟现实等各种应用中变得越来越重要。在一项研究中,韩国首尔大学团队提出了一种全新的4D Gaussian Splatting(4DGS)算法,并用于单目视频中的动态场景。

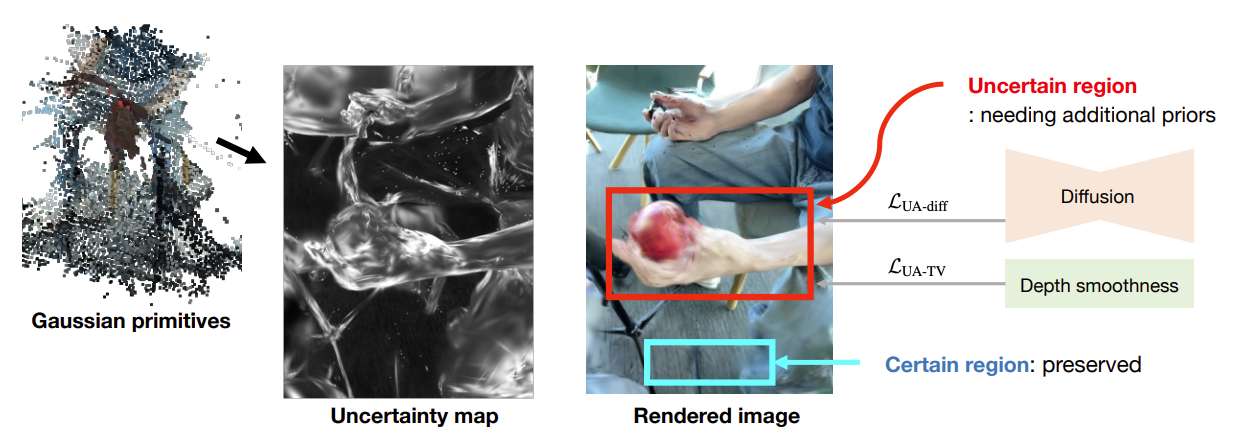

为了过拟合问题,研究人员引入了一种不确定性感知的正则化,以识别具有少量观测值的不确定区域,并基于扩散模型和深度平滑选择性地在相关区域施加额外的先验。所述方法不仅提高了新视图合成的性能,又提高了训练图像重建的质量。

团队同时确定了快速移动动态区域中4DGS的初始化问题,亦即SfM算法无法提供可靠的3D landmark。为了在所述区域中初始化高斯基元,他们提出了一种使用估计深度图和场景流的动态区域密度化方法。实验表明,这一解决方案提高了4DGS视频重建的性能,并且在few-shot静态场景重建中同样可以达到相当出色的效果。

......(全文 1612 字,剩余 1293 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限