DiVR:基于多模态Transformer的VR场景人体轨迹预测模型

强调了使用VR数据集进行情景感知人类轨迹建模的优势

(映维网Nweon 2025年04月22日)虚拟环境为收集人类行为的详细数据提供了丰富和可控的设置,为预测动态场景中的人类轨迹提供了独特的机会。然而,大多数现有方法都专注于静态情景,而没有考虑用户特定的因素。

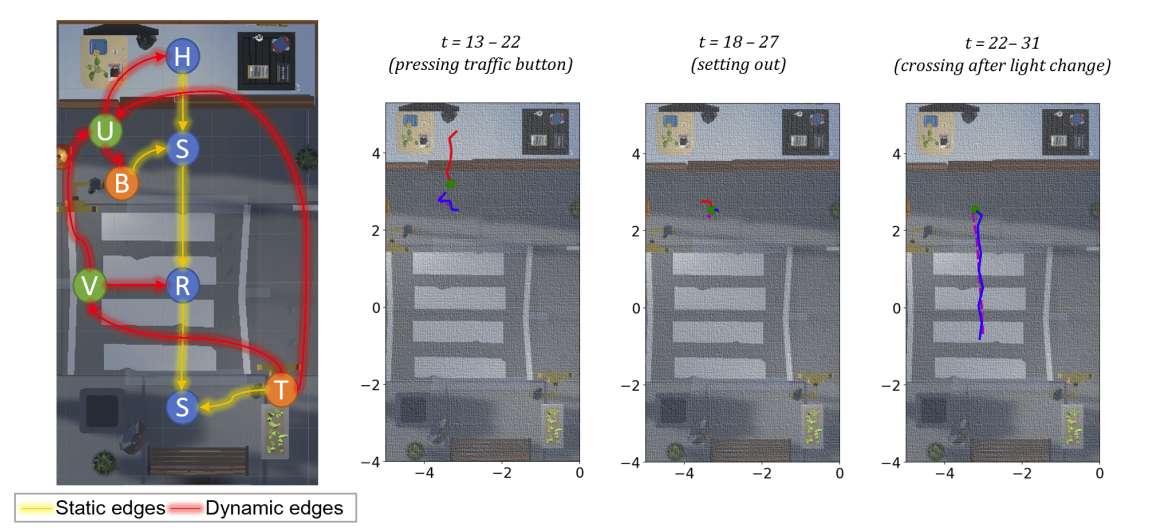

所以利用CREATTIVE3D数据集,法国蔚蓝海岸大学和普瓦提埃大学团队在VR场景中记录了各种情况的轨迹,包括过马路任务和模拟的视觉障碍等。

他们提出了多元语境VR人体运动预测DiVR。这个基于Perceiver架构的跨模式transformer使用异构图卷积网络集成了静态和动态场景语境。大量的实验表明,与其他模型和静态图相比,DiVR具有更高的精度和适应性,并强调了使用VR数据集进行情景感知人类轨迹建模的优势,而且在增强元宇宙用户体验方面具有潜在的应用。

......(全文 1459 字,剩余 1156 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限