日本团队分享基于预训练VQGAN的高效全景图像合成方法2S-ODIS

不仅可以生成高质量的全向图像,同时大大缩短了训练时间

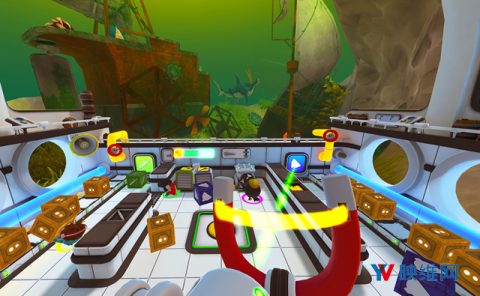

(映维网Nweon 2025年02月19日)全向图像越来越多地应用于虚拟现实和社交网络等领域。然而,与普通视场图像相比,它们的可用性相对有限,因为需要专门的摄像头来拍摄全向图像。所以,业界已经提出了数种基于生成对抗网络(GAN)的方法来合成全向图像,但由于不稳定性和/或大量的时间消耗,它们在模型的训练中表现出困难。

针对相关问题,日本上智大学团队提出了一种新的全向图像合成方法2S-ODIS ,它不仅可以生成高质量的全向图像,同时大大缩短了训练时间。这是通过使用在大规模NFoV图像数据库(如ImageNet)预训练的Vector Quantized GAN模型而不进行微调来实现。

由于预训练模型不能表示等矩形投影(ERP)中全向图像的畸变,所以不能直接应用于ERP中的全向图像合成。

针对这个问题,研究人员采用两阶段结构,首先在ERP中创建全局粗略图像,然后通过整合多幅更高分辨率的局部NFoV图像对图像进行细化,以补偿ERP中的畸变,这两种结构都是基于预训练的VQGAN模型。所以,所提出的2S-ODIS方法将OmniDreamer中的训练时间从14天减少到更高图像质量下的4天。

......(全文 1202 字,剩余 788 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限