中外研究揭示NeRF模型在后门攻击中的安全漏洞

尽管NeRF通过高效和逼真的场景合成对3D重建产生了变革性影响,但它对恶意攻击的脆弱性构成了一个值得注意且在很大程度上遭到忽视的安全挑战

(映维网Nweon 2025年01月20日)神经辐射场(NeRF)代表了计算机视觉的重大进步,提供了基于隐式神经网络的场景表示和新颖视图合成能力。它的应用跨越多个领域,包括虚拟现实/增强现实等。然而,尽管NeRF得到了广泛采用,但其稳健性和安全性在很大程度上尚未未得到探索。

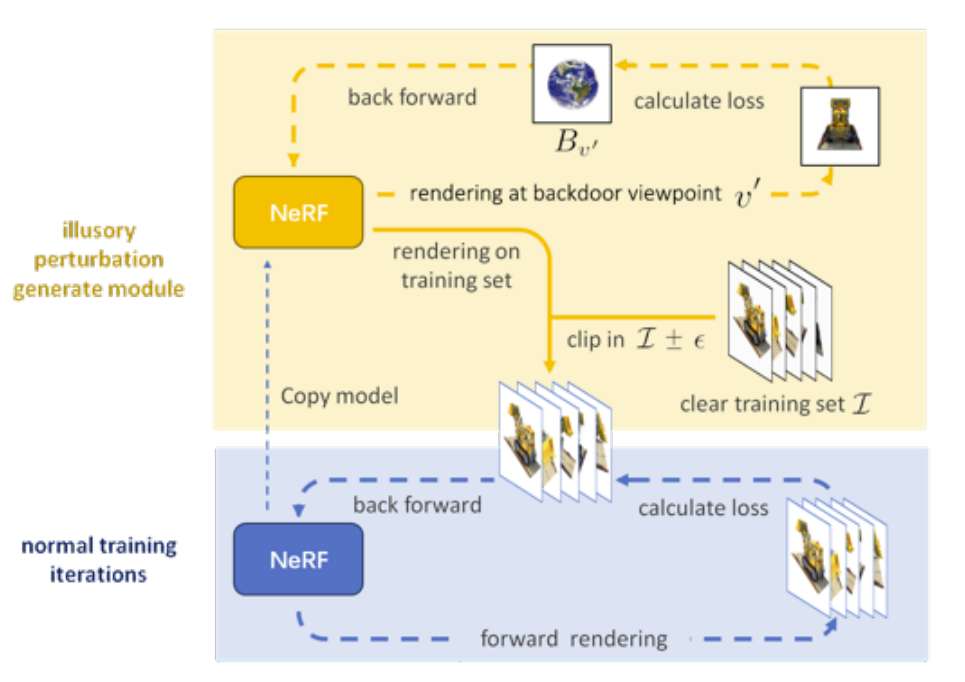

在一项研究中,中国海洋大学,德国萨尔大学,广州软件学院,西安电子科技大学团队引入了Illusory Poisoning Attack against Neural Radiance Fields(IPA-NeRF)。所述攻击包括在NeRF中嵌入一个隐藏的后门视图,当提供指定的后门视图时,允许它产生预定的输出,同时保持标准输入的正常性能。

这个攻击专门用于在特定位置欺骗下游模型,同时确保从其他角度无法检测到NeRF中的任何异常。实验结果证明了攻击的有效性,它可以在不影响其他视图的情况下,成功地在指定视点呈现出所需的错觉。值得注意的是,团队通过仅对训练集引入小扰动来实现这种攻击。

......(全文 1414 字,剩余 1021 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限