研究员展示高质量实时对话互动的数字化身生成技术

将用户上传的照片转换为能够参与实时对话互动的数字化身

(映维网Nweon 2024年12月25日)业界正积极探索数字化身生成技术。在一项研究中,斯蒂文斯理工学院,佐治亚理工学院,以及伊利诺伊大学厄巴纳-香槟分校的研究人员介绍了一个基于生成式模型的高质量实时交互框架。

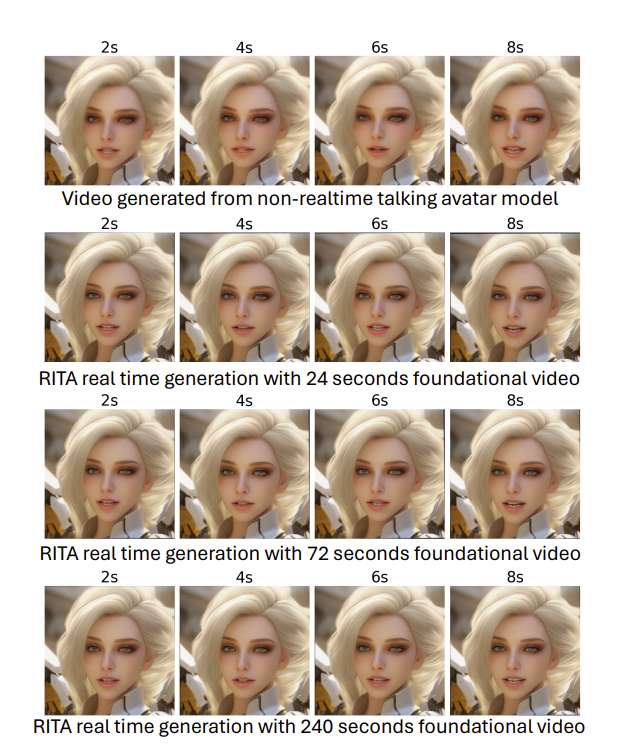

名为RITA的解决方案能够将用户上传的照片转换为能够参与实时对话互动的数字化身。通过利用生成式建模的最新进展,团队开发了一个多功能平台,它不仅可以通过动态会话虚拟化身增强用户体验,而且可以为虚拟现实和交互式游戏中的应用开辟新的途径。

团队指出,这项研究展示了集成计算机视觉和自然语言处理技术以创建身临其境和交互式数字角色的潜力,并推动了我们与数字内容交互的界限。

将单个图像动画化以创建动态语音驱动的面部动画是人工智能、计算机视觉和多媒体技术的交汇点。生成模型的出现极大地推动了有声视频的创作,将曾经静止的描述转变为生动的语音表现。

但由于视频生成的固有延迟,所述领域面临着挑战,因为将图像和音频转换为无缝视频序列需要大量的计算资源和时间,这通常使实时应用难以实现。

......(全文 1158 字,剩余 722 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限