清华大学提出从单图像生成360度高质量连贯视频的新方法

为虚拟现实等领域的多媒体应用铺平了道路

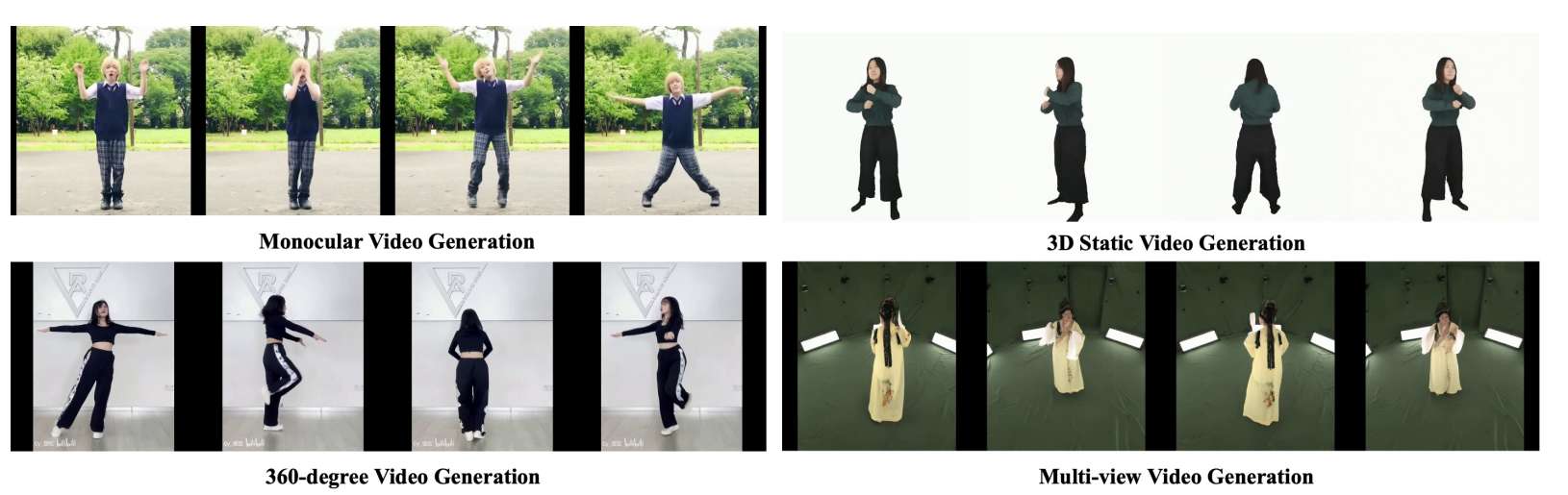

(映维网Nweon 2024年11月29日)在一项研究中,清华大学团队提出了一种从单个图像生成360度高质量,时空连贯人类视频的新方法。所述框架结合了diffusion transformer在捕获跨视点和时间全局相关性的优势,以及CNN用于精确条件注入的优势。

解决方案的核心是一个hierarchical 4D transformer架构,它可以将自关注分解为视图、时间步长和空间维度,从而实现对4D空间的高效建模。通过将人的身份、camera参数和时间信号注入各自的transformer,可以实现精确的调节,并且克服了以前基于生成对抗网络或vanilla diffusio模型的方法的局限性

为了训练这个模型,团队收集了一个多维数据集,包括图像、视频、多视图数据和有限的4D镜头,以及量身定制的多维训练策略。大量的实验证明了所述方法能够合成360度逼真,连贯的人体运动视频,从而为虚拟现实等领域的多媒体应用铺平了道路。

......(全文 1807 字,剩余 1484 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限