Meta XR Core SDK v71版本纳入了共同定位发现功能

v71版本

(映维网Nweon 2024年11月29日)根据VTuber CafeSingularity, Meta Mixed Reality Utility Kit(MRUK)的v71版本新增了即时放置和键盘透视功能,而Meta XR Core SDK的v71版本则纳入了共同定位发现功能。

MRUK是一个引擎级的实用工具功能,预制件,工具和示例场景的集合,可以帮助你更快地构建空间感知应用程序。它增加了底层MR API,减少了开发者必须编写的样板代码的数量,这样你就可以腾出时间专注于其他允许应用脱颖而出的方面。

根据介绍,v71版本现在可以在没有场景扫描的情况下将虚拟对象放置在表面之上,并且能够显示任何键盘的透视视图。

在过去,Quest应用需要利用设置过程生成的场景网格来将虚拟对象放置在真实表面之上,但如果是在一个用户没有扫描过的房间里利用场景网格,用户则需要再次经历设置过程。

但现在,v71版本不再需要使用场景网格,即时放置功能可以利用Depth API来提供光线投射,从而允许在表面生成虚拟对象或界面。

但需要注意的是,这只适用于生成简单的固定对象和界面。对于复杂和移动场景,你依然需要场景网格。

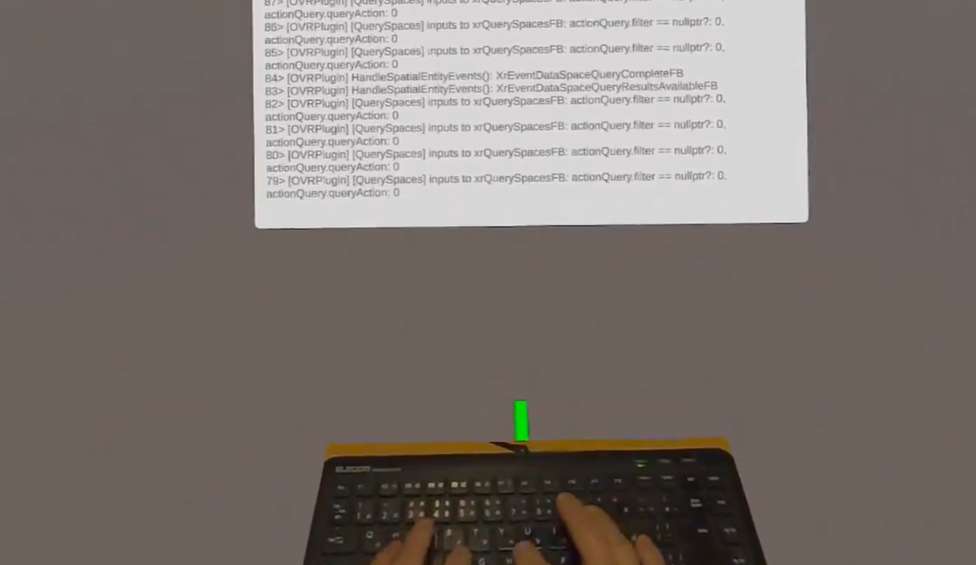

另外,Mixed Reality Utility Kit(MRUK)的v71版本允许呈现兼容键盘的透视视图。当用户在虚拟空间中操作时,系统可以呈现键盘的透视视图,而不是渲染它的数字模型。

值得一提的是,Meta XR Core SDK的v71版本已经纳入了共同定位发现功能功能。

在过去,Quest头显主要是通过Shared Spatial Anchors AP支持相同空间的本地多人游戏,称为亦即Colocation共同定位。

但所述过程涉及一系列的菜单,从而给用户体验造成摩擦。现在,新纳入的Colocation Discovery API可以利用头显的蓝牙连接,以允许设备向附近的头显发送少量数据(1024字节),从而帮助开发者构建一个简化的本地多人用户体验。其中一个头显托管一个会话,而附近的头显则自动加入。