卡内基梅隆大学展示AR/VR体表输入,用皮肤模仿触屏手势

查看引用/信息源请点击:techxplore

团队希望最终设计出一种仅使用标准AR/VR头显附带的传感器就能提供触觉反馈的控制器。

(映维网Nweon 2024年11月18日)在AR/VR体验中,用户的手臂和手可以为触控输入提供方便的触觉表面。先前的研究表明,与目前常见的悬空操作相比,体表输入具有显著的速度、准确性和人体工程学优势。

卡内基梅隆大学日前介绍了一种基于人工智能的人机界面EgoTouch,并允许用户将自己的身体变成AR/VR控制器。

在这项研究中,团队展示了高精度的裸手皮肤输入,并且仅仅使用标准XR头显所附带的RGB摄像头。

研究人员指出:“试着抬起你的手指,看看当你用它伸向另一个手并触及皮肤时会发生什么。你会注意到只有当你触控皮肤时才会出现这种阴影和局部皮肤变形。如果我们能检测到,我们就可以训练一个机器学习模型来做同样的事情,而这基本上就是我们所做的事情。”

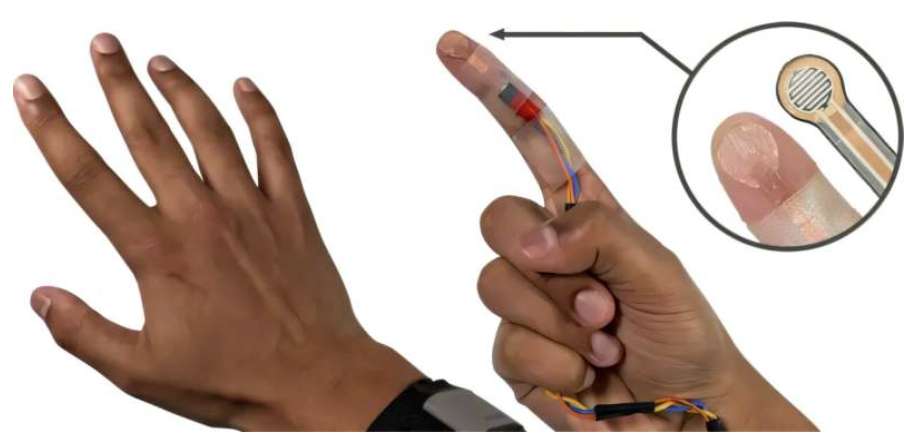

为了给EgoTouch收集数据,团队在食指和手掌安装一个定制的触控传感器。传感器可以在非摄像头视场下收集不同类型的触碰在不同力量下的数据。然后,模型学习将阴影和皮肤变形的视觉特征与触碰和力联系起来,无需人工注释。

......(全文 911 字,剩余 498 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限