剑桥大学提出高效准确的基于稀疏神经辐射场的视觉再定位框架VRS-NeRF

“希望这一方法能够成为将NeRF应用于视觉定位任务的新基准。”

(映维网Nweon 2024年10月25日)视觉再定位是虚拟现实/增强现实等领域的关键技术。经过几十年的探索,APR、SCR和HMs已经成为最流行的框架。然而,尽管APR和SCR的效率很高,但它们的精度有限,特别是在大型户外场景中。HMs是准确的,但需要存储大量的二维描述符进行匹配,导致效率较低。

针对这个问题,剑桥大学提出了一种高效、准确的基于稀疏神经辐射场的视觉再定位框架VRS-NeRF。

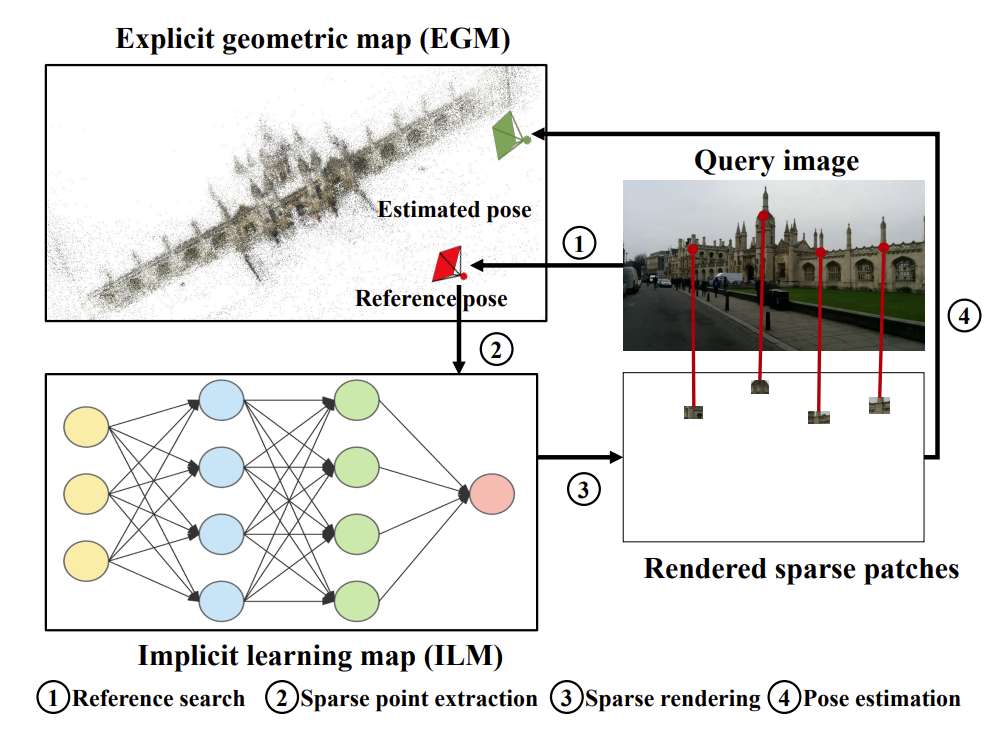

具体来说,团队引入了用于3D地图表示的显式几何地图EGP和用于稀疏patch绘制的隐式学习地图ILM。在定位过程中,EGP提供空闲2D点的先验信息,ILM利用稀疏点绘制具有稀疏NeRF的patch进行匹配。这允许丢弃大量的2D描述符,从而减小地图大小。

另外,仅对有用的点而不是整个图像中的所有像素渲染patch,这可以大大减少了渲染时间。团队表示,框架既继承了HMs的准确性,又克服了其低效率的缺点。在7Scenes,CambridgeLandmarks和Aachen数据集的实验表明,所述方法比APR和SCR提供了更好的准确性,并且性能接近HMs,但效率更高。

视觉定位的目的是估计已知环境中给定图像的旋转和位置。视觉定位作为一项基本的计算机视觉任务,是虚拟现实/增强现实等各种应用的关键技术。经过几十年的探索,业界已经提出了许多优秀的方法,大致可分为APR、SCR和HMs。APR将地图嵌入到高级姿态特征中,并使用多层感知MLP预测六自由度姿态。它们的速度很快,特别是在大规模场景中,但由于隐含的3D信息表示,它们的准确性有限。

......(全文 1448 字,剩余 905 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限