高通提出用于立体视频串流LLSS的低延迟神经编解码器

实现快速高效的低延迟立体视频串流

(映维网Nweon 2024年10月17日)虚拟现实等新视频模式的兴起增加了对高效多视点视频压缩方法的需求,包括率失真(R-D)性能方面,以及延迟和运行时间方面。尽管新近提出的立体声视频压缩方法显示出相当出色的性能,但它们顺序压缩左视图和右视图,导致并行化和运行时性能差。

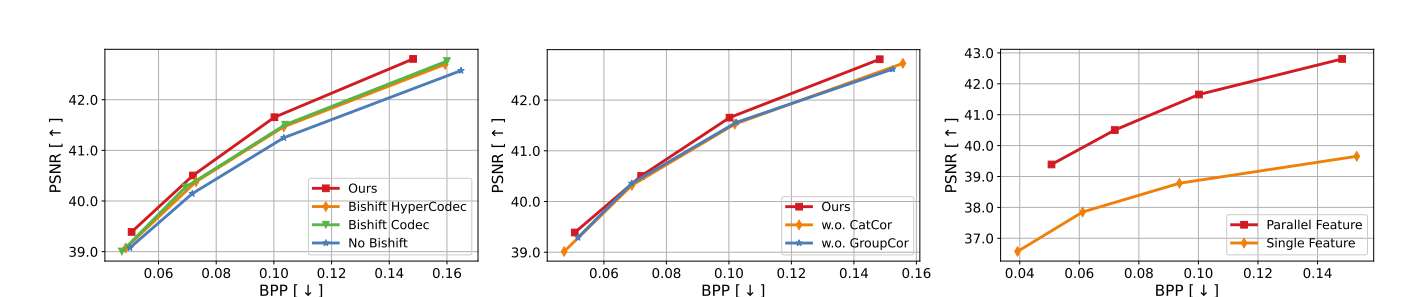

针对这个问题,高通提出了用于立体视频串流LLSS的低延迟神经编解码器。这是一种全新的并行立体视频编码方法,旨在实现快速高效的低延迟立体视频串流。

与现有方法采用序列交叉视角运动补偿不同,LLSS引入双向特征移位模块,直接利用视图之间的相互信息,并通过联合交叉视角先验模型进行熵编码,从而有效地对视图进行编码。由于这种设计,LLSS并行处理左视图和右视图,最大限度地减少了延迟。另外与现有的神经和传统编解码器相比,它大大提高了性能。

......(全文 1253 字,剩余 920 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限