美国军方、加州大学等联合提出通过文本创建3D场景环境

通过简单的用户命令创建身临其境和逼真的3D环境

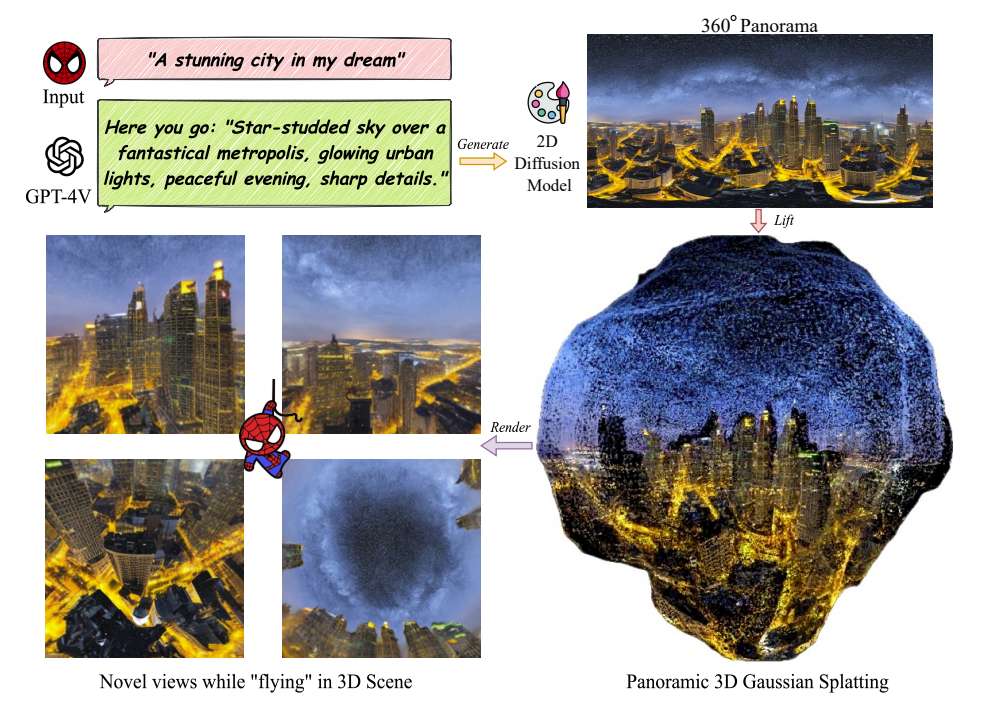

(映维网Nweon 2024年09月10日)对虚拟现实应用日益增长的需求凸显了制作沉浸式3D asset的重要性。在一项研究中,美国军方下属的DEVCOM Army Research Laboratory陆军研究实验室,加州大学和得州大学奥斯汀分校提出了一种从文本到3D的360度场景生成管道,而它可以在数分钟内为in-the-wild环境创建全面的360度场景。

文生3D在VR/MR等领域存在巨大潜在应用,并极大地推动了旨在开发大规模沉浸式场景内容创作可靠方法的研究工作。最近在2D领域的发展已经看到了使用大规模预训练扩散模型成功生成或编辑高质量和适应性强的图像/视频,允许用户按需生成定制内容。

在2D之外,3D内容的生成,特别是3D场景的生成,受到数据对有限可用性的限制。所以,3D内容创建的努力往往依赖于利用大规模2D模型。然而,相关方法往往存在渲染质量较低的问题,主要是因为2D模型的多视图不一致,并且难以扩展到具有精细细节纹理创建的场景尺度3D结构,特别是对于面向外的视点和无限场景规模的户外场景。

......(全文 954 字,剩余 572 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限