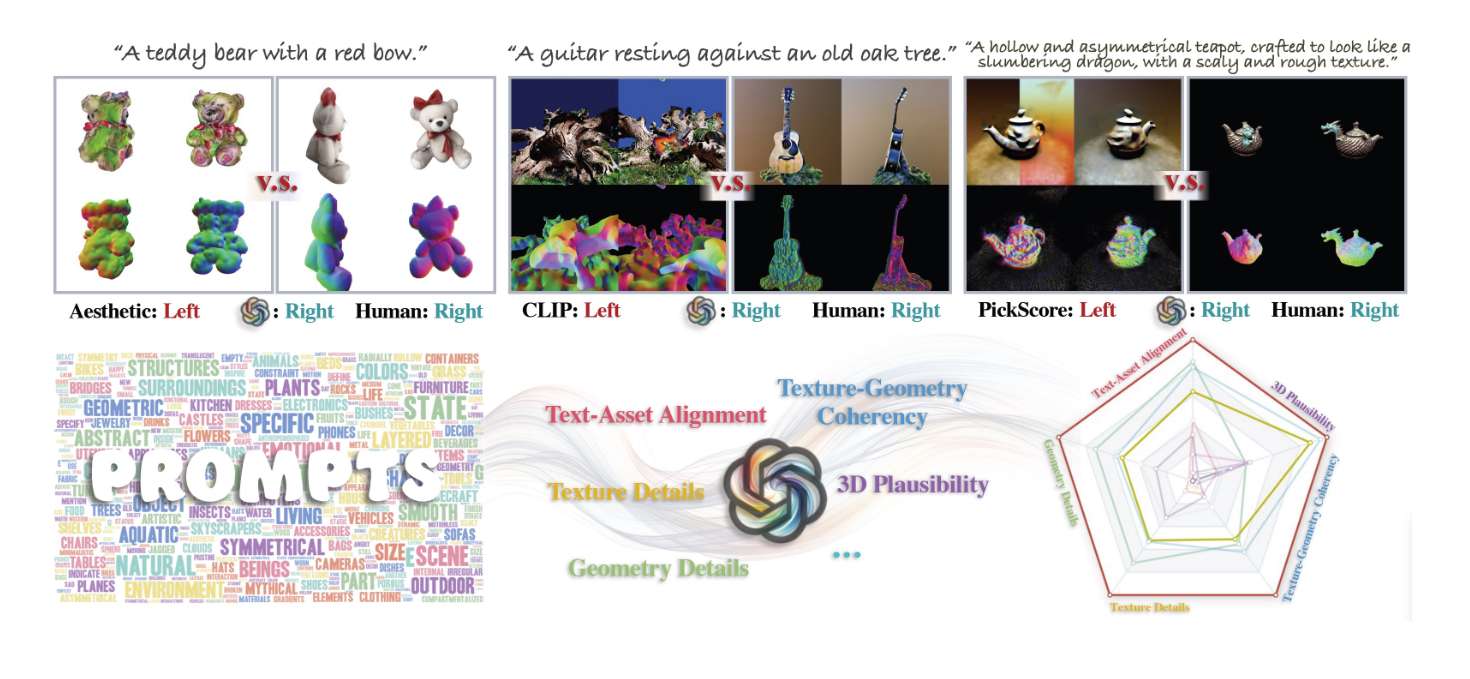

中美研究员利用GPT-4V为XR文生3D场景建立评估指标

利用GPT-4V建立一个可定制、可扩展和与人类判断一致的评估指标

(映维网资讯)文生图(Text to Image),文生视频(Text to Video)和文生3D(Text to 3D)等领域正在蓬勃发展。可以想象,所述的文生技术可以与XR结合,为XR快速生成各种逼真场景。

但技术的发展初期可能存在缺乏可靠评估指标的问题。在围绕文生3D的研究中,由香港中文大学、斯坦福大学、Adobe、南洋理工大学和上海人工智能实验室组成的团队表示,GPT-4V是一个能够与人类判断保持一致的评估指标,可以有效地提供针对文生3D模型的高效和全面评估。

在神经三维表示,广泛数据集发展,可扩展生成式模式,以及用于3D生成的文本-图像基础模型的创新应用等一系列突破推动下,文生3D领域在过去的一年中取得了显著的进展。考虑到这一势头,我们有理由预计文生3D生成模型领域的研究工作和进展将迅速增加。

......(全文 1905 字,剩余 1590 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限