Meta专利分享通过手机扫描真实环境为VR生成对应虚拟环境

只需拿出手机扫描一下真实环境,然后即可生成一个对应的虚拟环境并在VR头显中显示

(映维网Nweon 2024年03月08日)你是否曾想象过这样一个场景:只需拿出手机扫描一下真实环境,然后即可生成一个对应的虚拟环境并在VR头显中显示。在名为“Method of generating a virtual environment by scanning a real-world environment with a first device and displaying the virtual environment on a second device”的专利申请中,Meta就提出了这样一个方法。

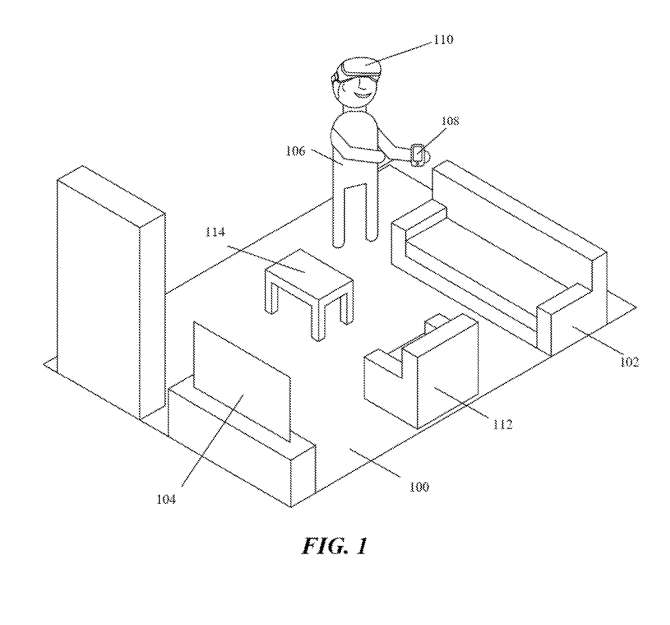

图1举例说明了一个真实世界的环境。举个例子,现实世界的环境可以是一个客厅。如图1所示,真实环境包括沙发102和112、咖啡桌114和电视104。在具体实施例中,真实世界环境可包括具有第一设备108和第二设备110的主机用户106。第一设备108可以是包括摄像头的智能手机,第二设备110可以是头显。

主机用户可以创建虚拟环境来托管客人并与之交互。为了生成虚拟空间,主机用户106将用第一设备108扫描客厅100。

......(全文 3443 字,剩余 3136 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限