微软AR/VR专利分享用辐射场+体三维计算动态场景合成图像

使动态场景的合成图像能够以可控的方式生成

(映维网Nweon 2024年02月07日)在传统的计算机图形学中,计算动态场景的合成图像是一项复杂的任务,因为需要对场景及其动态进行三维建模。

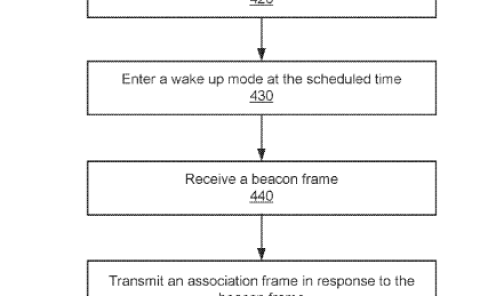

在名为“Computing images of controllable dynamic scenes”的专利申请中,微软介绍了一种使用辐射场和体三维绘制的方法。

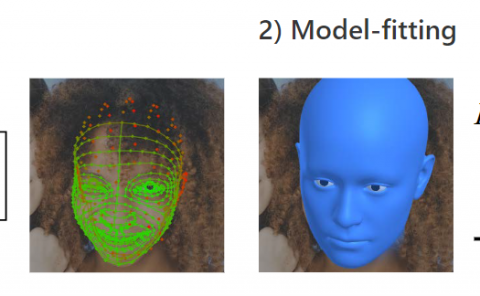

辐射场参数化表示一个辐射场,它是从5D空间到4D空间的函数,其中辐射值是场中每对3D点和2D视图方向的已知值。亮度值由颜色值和不透明度值组成。亮度场参数化可以是一个训练有素的机器学习模型,其学习亮度值与对3D点和视图方向之间的关联。

体三维绘制方法通过检查沿形成图像的射线的点的亮度值,从特定camera视点的亮度场计算图像。

发明描述的技术提供了一种精确的方法来控制动态场景的图像如何动画。用户或自动化过程能够指定参数值。通过这种方式,用户或自动化过程能够精确地控制要在合成图像中描绘的3D对象的变形。在其他示例中,自动化过程的用户能够使用来自物理引擎的动画数据来精确控制要在合成图像中描述的3D对象的变形。

简单来说,发明描述了一种以可控方式计算动态场景图像的方法,以便用户或自动化过程能够轻松地控制动态场景的动画。

......(全文 3418 字,剩余 2973 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限