高通专利提出优化AR/VR手势交互的对象检测和追踪配置

优化的对象检测和追踪配置

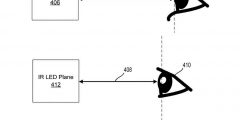

(映维网Nweon 2024年01月04日)扩展现实设备可以通过摄像头来检测、追踪和识别目标事件或对象。传统的追踪系统可能无法正确地检测用户的手势,例如通过用户的裸手或通过用户持有对象执行的姿势。

在名为“Object detection and tracking in extended reality devices”专利申请中,高通提出了一种优化的对象检测和追踪配置。

在一个实施例中,对象检测和追踪设备可以包括一个或多个光学元件,并且可以检测虚拟环境中用户的一个或多个对象或身体部位,以识别用户执行的输入手势。目标检测和追踪设备可以在摄像头的视场中检测对象,并确定所述对象对应于特定用户。

例如,对象检测和追踪设备可以确定对象对应于用户并且正在用于提供输入手势。所述对象检测和追踪设备可以另外或可选地确定所述对象不对应于所述用户,所以将不用于提供输入手势。

......(全文 4367 字,剩余 4044 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限