英伟达提出从单视图肖像图像重建动画3D化身头部

从单视图肖像图像重建和动画3D化身头部

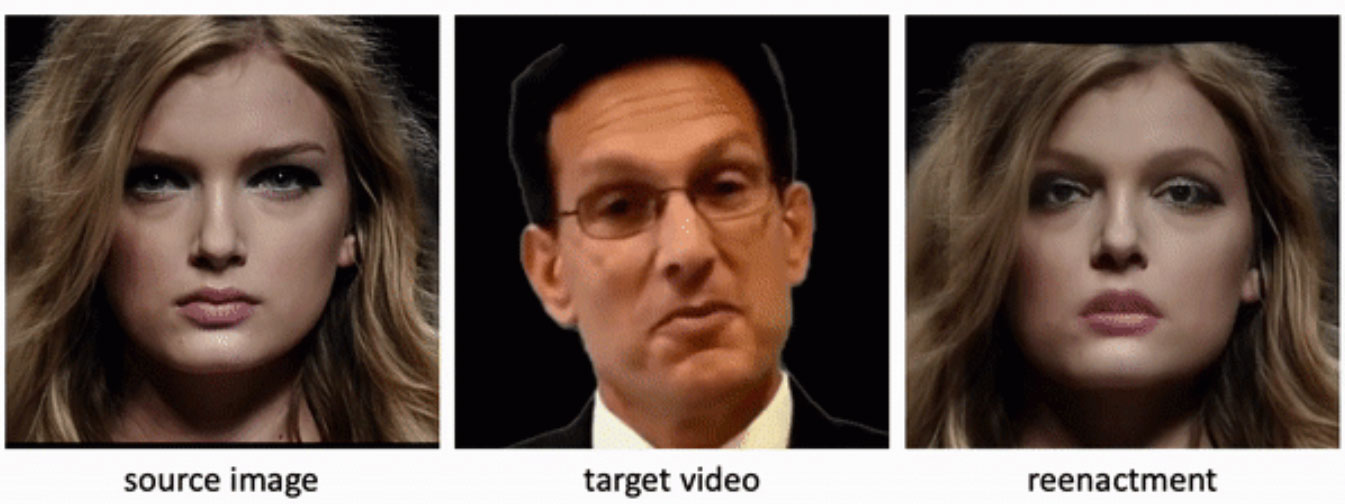

(映维网Nweon 2023年12月26日)利用目标图像运动(即姿势和表情)来动画化Avatar在AR/VR等领域得到了广泛的应用。然而,合成符合给定身份和动作的逼真化身提出了两个主要挑战:效率和高保真度。

针对这个问题,英伟达的研究人员提出了一种从单视图肖像图像重建和动画3D化身头部的方法。团队提出的框架不需要针对个人进行优化就可以基于单视图图像泛化到未见过的身份,而且能够捕获面部区域内外的特征细节。

利用目标图像运动来动画化源肖像图像是计算机视觉领域的一个长期课题。但如上所述的两个挑战一直困扰着行业的发展。

效率要求模型可以泛化到任意不可见的身份和运动而不需要在推理过程中进一步优化。高保真度则要求模型不仅忠实地保留输入图像中的复杂细节,而且在必要时能够产生所需的幻觉,例如当嘴巴从闭合到打开转换时生成牙齿。

基于3D Morphable Models(3DMM)的传统方法学习可以有效地预测任意来源人像图像的形状、表情、姿势和纹理的网络。然而,由于有限的网格分辨率和粗糙的纹理模型,相关方法在合成真实细节方面往往不足。另外,它们只关注面部区域,而忽略了其他个人特征,如发型或眼镜。

......(全文 3730 字,剩余 3281 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限