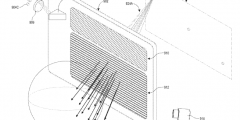

微软AR/VR专利分享解决摄像头不同视角产生的遮挡或视差问题

提供不会因摄像头的不同视角而产生遮挡或视差问题的环境正确视图

(映维网Nweon 2023年11月03日)由于位置无法对应眼睛,对于基于摄像头透视的头显,用户可能很难正确地感知环境中对象相对于定义空间的空间关系。另外,同一定义空间内的多个用户相对于定义空间外的对象可能具有不同的视角。

所以在名为“Perspective-dependent display of surrounding environment”的专利申请中,微软提出了一种正确表示所定义空间的环境图像,尤其是在汽车这样的移动平台中时。简而言之,计算系统构建围绕所定义空间的环境的至少一部分的深度图和强度数据。然后将强度数据与深度图位置相关联。

另外,计算系统可以获得关于用户在所定义空间内的姿势信息,并基于所述用户的姿势确定所述用户正在注视的所定义空间周围环境的一部分。计算系统进一步从用户的角度获得表示环境部分的图像数据,

然后,计算系统根据用户视场范围内的深度图位置的强度数据生成用于显示的图像。通过这种方式,由一个或多个摄像头获得的环境视图可以重新投影到用户的视角,从而提供不会因摄像头的不同视角而产生遮挡或视差问题的环境正确视图。

......(全文 3921 字,剩余 3495 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限