苹果专利用神经网络估计2D摄像头图像中的Avatar用户情绪

通过神经网络来帮助估计摄像头2D图像中描述的用户情绪

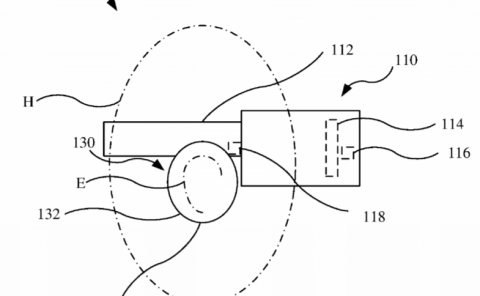

(映维网Nweon 2023年11月01日)现有的Avatar系统通常无法传达细微的面部表情或情绪状态。所以在名为“Emotion detection”的专利申请中,苹果介绍了一种通过神经网络来帮助估计摄像头2D图像中描述的用户情绪,从而优化图形建模系统的方法。

具体来说,发明使用自编码器神经网络来捕获“中性”和“表情”面部模型的latent变量表示。模型可以离线开发并存储在单个设备以供运行或实时使用。基于一的非常有限的数据样本,可以使用额外的神经网络或统计滤波器来选择性地加权第一个神经网络模型的latent变量,以提供一个逼真的中立Avatar。

所述Avatar可以与表情神经网络结合使用,并在实时操作期间由音频和/或视觉输入驱动,以生成特定个体的逼真Avatar。

在一实施例中,可以基于从表情自编码器的训练产生的数据来估计在2D图像中描述的情绪。具体而言,在训练自编码器时,获得一组具有latent向量的图像对。latent向量可以表示与表情相对应的三维特征。可以训练诸如表情CNN这样的神经网络,以从latent向量估计情绪。

......(全文 2788 字,剩余 2391 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限