Meta为Quest开发者发布一系列工具,助力开发创作和迭代

Project Setup Tool,Building Blocks和Meta XR Simulator

(映维网Nweon 2023年09月29日)在Connect大会,Meta发布了一系列的工具来帮助开发者更快地从构思走向迭代。你可以通过最新的功能增强创作过程,并减少需要设置和开始构建的时间。

下文将介绍Project Setup Tool,Building Blocks和Meta XR Simulator,以及它们如何协同工作以增强你的应用开发工作。值得一提的是,Unity的AR Foundation现在提供了对Quest 3和Quest Pro的支持。

使用Project Setup Tool for Unity减少调试和设置时间

与Integration SDK v49一起发布的Project Setup Tool工具旨在帮助减少设置SDK的时间。这个项目设置工具会自动向你提醒各种问题,并通过一个大型自动修复库来帮助你修复它们。

为了帮助你清楚理解影响项目的任何兼容性、渲染或SDK问题,Project Setup Tool的警报同时会根据紧急程度进行分类,从而帮助你优先考虑需要、推荐和可选的内容。

所有使用Unity构建内容的开发者现在都可以访问Project Setup Tool,而团队将继续在每个新SDK版本中添加更多相关的自动修复和支持工具。更多信息请访问这个文档。

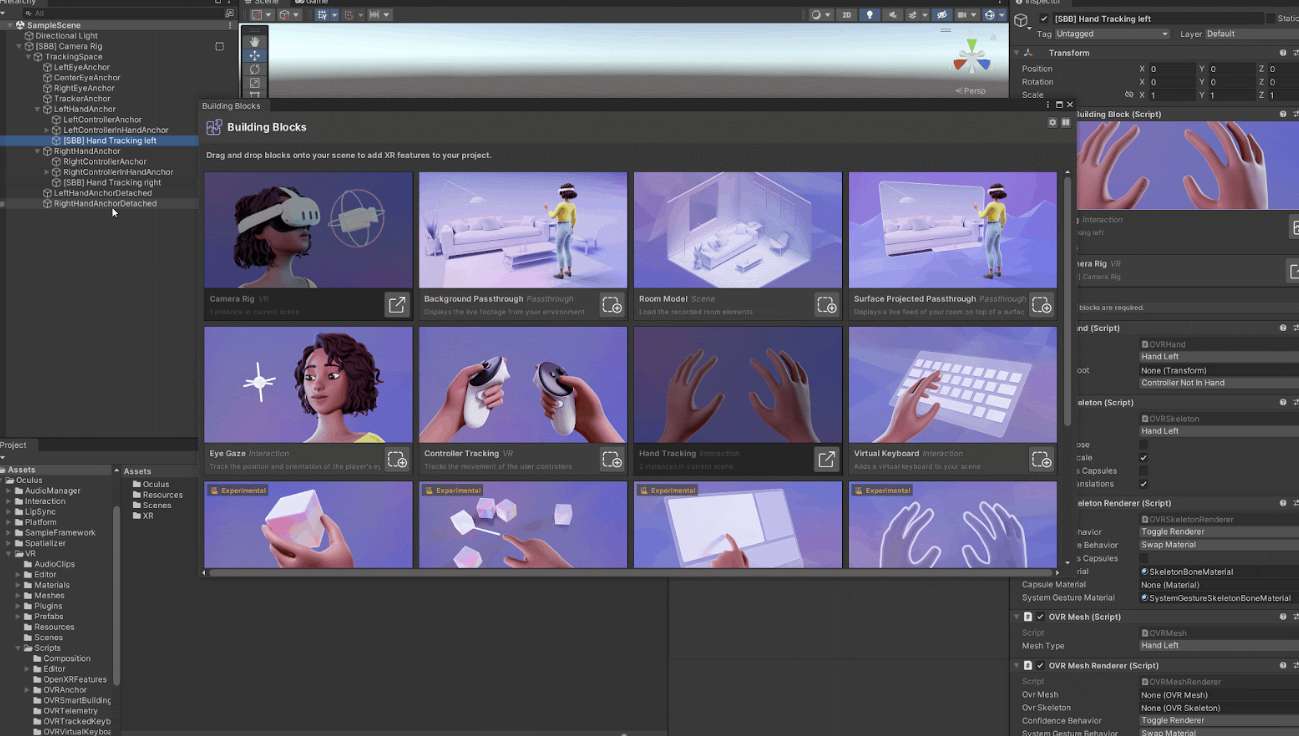

通过Building Blocks的拖放功能来丰富你的体验

Building Blocks是Integration SDK v57的一个全新实验性功能,旨在帮助你轻松发现和添加Presence Platform功能,如Passthrough透视和手部追踪。

Building Blocks可以帮助提升你的开发速度,而这主要归功于一个允许你简单地将其拖放到项目中的功能库,从而为你提供快速原型设计和向应用添加新功能的强大解决方案。所述工具允许开发者能够在Unity中构建一个包含用以驱动Meta Quest头显交互,MR和社交临在等功能的“Blocks”库。只需点击几下,你就可以访问一个允许你创建令人难以置信的沉浸式和混合现实体验的功能库。

另外,功能描述,搜索和过滤功能可以帮助你发现新的功能,从而丰富你当前的应用程序。在一开始,Building Blocks将包括对12个Blocks的支持:

Passthrough透视

Controller Tracking控制器追踪

Hand Tracking手部追踪

Camera Rig

Surface Projected Passthrough曲面投影透视

Room Model房间模型

Eye Gaze眼睛注视

Virtual Keyboard虚拟键盘

Synthetic Hands合成手

Throwable Item可投掷项目

Pointable Item可指向项目

Pokeable Item可点戳项目

Grabbable Item可抓取项目

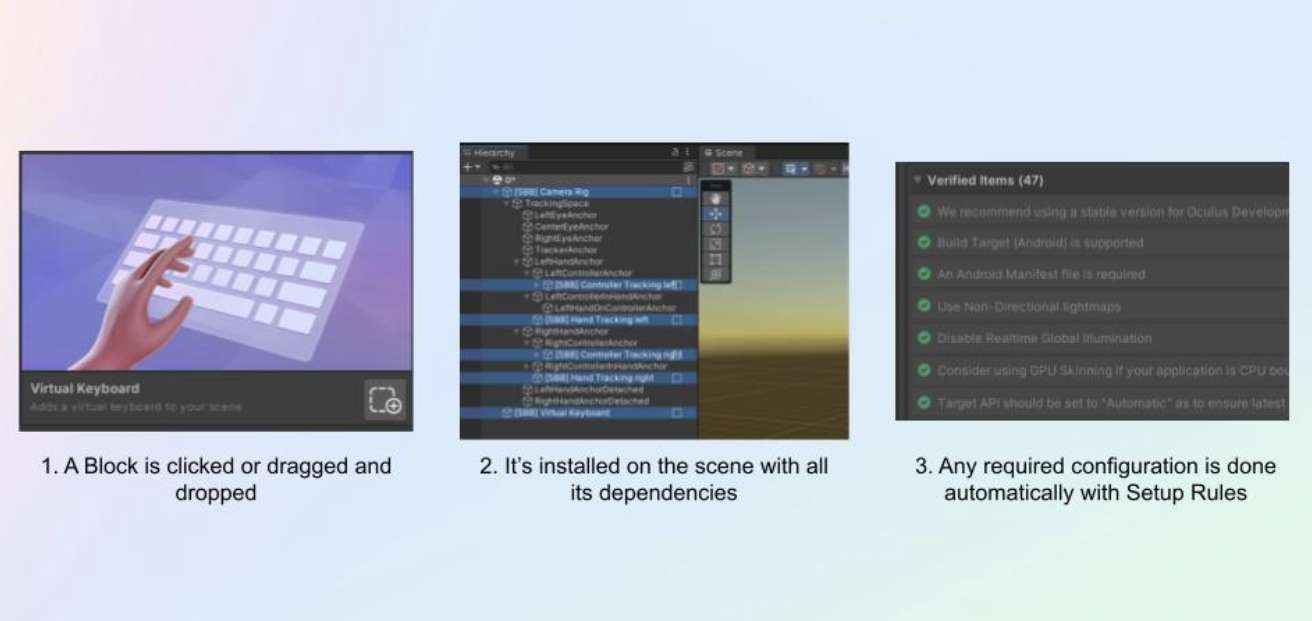

一旦你找到一个想要添加的Blocks,你就可以把它拖放到项目之中,并通过三个简单的步骤进行设置。下面是它的工作原理:

Blocks归类为ScriptableObjects,每个Blocks都包含依赖项、设置规则、单元测试等,以确保你拥有所需的功能逻辑,并且相关特性可以独立工作,或可以与其他功能结合使用。设计利用物理和虚拟空间的体验可能非常困难,但通过使用提供的Blocks,你可以更轻松地组合功能。

这同时令迭代成为一个更有趣和更愉快的体验,允许你用一个已安装功能的工作板快速启动一个项目,然后自定义和配置它们以满足应用程序的独特需求,而不需要过多的时间和精力编码。

Building Blocks将作为Integration SDK v57的实验性功能。在接下来的几个月里,团队将添加对其他Blocks、自动测试、改进的UI和其他改进的支持。相关文档即将发布。

通过Meta XR Simulator进行更快迭代

无需物理设备,Meta XR Simulator可允许你快速、轻松地测试和改进应用程序的机制、设计和整体用户体验。这个模拟器是一个轻量级的XR运行时,允许你在API level模拟Meta Quest设备和功能,并通过实现更快的迭代和可扩展的自动化来节省你的时间和精力。Meta XR Simulator使你更容易进行日常开发,无需每次都戴上头显就可测试和调试应用程序。

使用Meta XR Simulator,你可以轻松测试和改进应用程序的机制、设计和整体用户体验。所述工具通过键盘和鼠标输入(或游戏控制器)模拟Quest头显和Touch控制器的运动和输入,使你可以轻松快速迭代应用程序。

除了更精简的迭代过程外,所述工具同时允许你模拟头显属性,如精确的视场和正确的显示分辨率。Meta XR Simulator是社交应用的宝贵工具,它支持在一台机器运行多个实例,因此独立开发者可以模拟和测试多个玩家的交互。

Meta XR Simulator同时通过合成环境服务器SES支持MR开发。其中,所述SES可以装载模拟物理世界的合成环境以及场景、直通和锚点等Presence Platform功能。

Meta XR Simulator支持Unity,Unreal和本地开发。更多信息请访问这个文档。

上述工具如何协同工作

当你使用上述工具时,MR项目的启动和迭代可以成为一个更加灵活和有效的过程。例如,一旦你安装了Integration SDK和Meta XR Simulator,你就可以启动一个新的Unity项目,并在项目设置工具中看到一切都设置正确,或者解决可能阻止项目正常运行的特定问题。

接下来,你可以启动Meta XR Simulator并设置SES,以便项目获得房间环境数据。MMeta XR Simulator菜单同时为你提供了几个房间选项。设置好环境后,你可以使用Building Blocks将Passthrough、手动追踪等功能拖放到项目中。添加房间模型同时可以通过自动标记环境中的所有场景锚点并使用可见网格来帮助你可视化房间数据的构造方式。现在你可以像在头显中一样自由地探索MR环境,但只需要使用鼠标和键盘或游戏控制器即可。

尽管测试和刺激环境在构建MR时非常有效,但使用追踪功能的测试性能和交互最好通过基于物理头显的工作流来完成。值得庆幸的是,如果你希望在应用中整合或迭代交互,你可以将IntegrationSDK功能拖到项目中,并启动Quest Link进行头显测试。

使用AR Foundation增加你的受众

Unity的AR Foundation现在提供了对Quest 3和Quest Pro的支持。有了AR Foundation,你只需构建一次MR应用程序,就可以在选择的任何生态系统发布它们,不仅仅只是Meta Quest。多亏了hooks,为多个平台创建MR应用变得更加容易,它可以让你简单地更新你的包,以便在添加时集成缺失的平台特定功能。更多信息请访问这个页面。