Meta研究员提出Pose-Guided模型,改善从单图像合成AR/VR新视图

pose-guided扩散模型

(映维网Nweon 2023年08月07日)从单个图像合成新视图已经成为众多虚拟现实应用程序提供沉浸式体验的基础问题。然而,大多数现有技术只能在有限的camera运动范围内合成新视图,或者不能在显著的camera运动下生成一致和高质量的新视图。

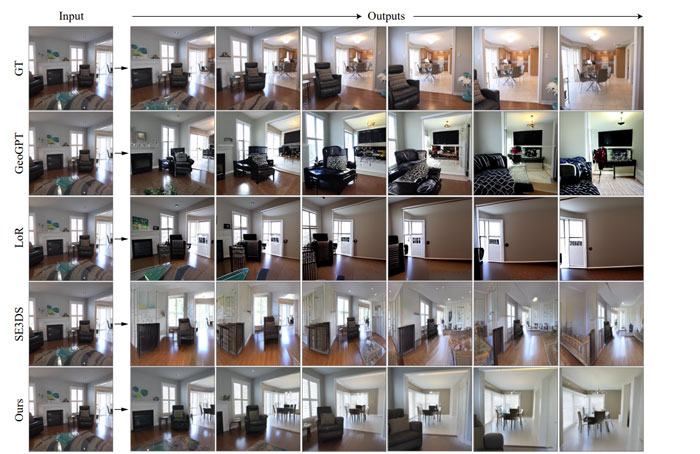

所以在名为《Consistent View Synthesis with Pose-Guided Diffusion Models》的论文中,马里兰大学和Meta的研究人员提出了一个pose-guided扩散模型,以从单个图像中生成一致的long-term新视图。他们设计了一个使用极线作为约束的attention层,以促进不同视点之间的联系。

从日常照片中提供沉浸感3D体验吸引了相当多的关注。它是广泛应用的基础技术,如3D照片,3D asset生成和3D场景导航。值得注意的是,业界在解决单图像视图合成问题方面取得了快速进展。

给定任意的窄视场图像,相关框架可以从新视点产生高质量的图像。然而,它们仅限于小camera运动范围内的视点。为了解决camera运动范围小的限制,业界提出了long-term single-image view synthesis。

......(全文 1425 字,剩余 1084 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限