Meta等研究员提出从视频重建动态辐射场的算法RoDynRF

不需要精确的camera姿势作为输入

(映维网Nweon 2023年07月21日)视频捕获并保存了生活中众多值得纪念的时刻。但在查看普通视频时,我们是从固定的视点感知场景,之后无法交互式地导航场景。动态视图合成技术旨在从任意camera角度和视点创建动态场景的逼真新视图。这种系统对于虚拟现实等创新应用至关重要。

动态辐射场重建方法旨在模拟动态场景的时变结构和外观。然而,现有的方法都假定通过运动构造SfM算法能够可靠地估计出精确的camera姿态。但所述方法并不一定可靠,因为SfM算法经常失败,或者在具有高度动态对象,次优纹理表面和旋转camera运动等具有挑战性的视频中产生错误的姿态。

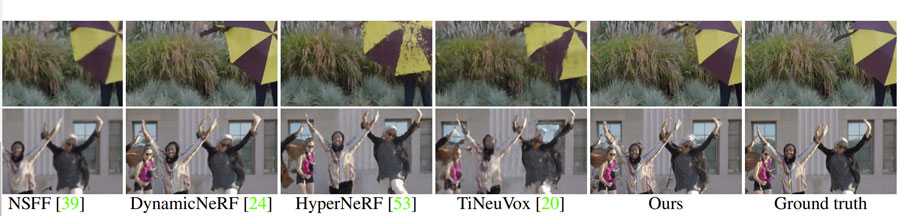

在《Robust Dynamic Radiance Fields》的论文中,Meta,台湾大学,韩国科学技术院和马里兰大学的研究人员提出了一种从视频重建动态辐射场的算法RoDynRF。不需要精确的camera姿势作为输入,它可通过联合估计静态和动态辐射场以及camera参数(姿态和焦距)来解决这一鲁棒性问题。大量的定量和定性实验都证明了所述方法的鲁棒性,而且研究结果显示了比目前最先进的动态视图合成方法更好的性能。

......(全文 1563 字,剩余 1156 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限