谷歌和康奈尔大学提出复杂运动场景单目视图的3D重建

系统保留了先前方法在模拟复杂场景和视图依赖效果方面的优势,但同时能够从具有无约束camera路径的复杂场景动态的长视频中合成逼真的新视图

(映维网Nweon 2023年07月17日)计算机视觉方法现在可以产生具有惊人质量的静态3D场景的自由视点渲染。但移动的场景又如何呢?从动态场景的单目视频中合成新视图是一个十分具有挑战性的动态场景重建问题。

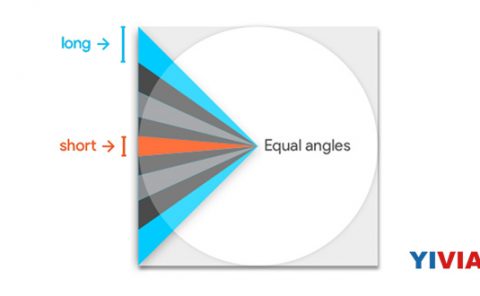

近来,业界在空间和时间合成新视图方面取得了进展,这主要得益于HyperNeRF和NSFF等新时变神经体三维表示,它们可以在基于坐标的多层感知器MLP中对时空变化的场景内容进行体三维编码。

但这种动态NeRF方法存在局限性,无法应用于in-the-wild视频。NSFF这种基于局部场景流的方法难以扩展到无约束camera运动捕获的较长输入视频,而HyperNeRF则局限于具有受控camera路径的对象中心场景,并且在具有复杂物体运动的场景中可能会失败。

在名为《DynIBaR Neural Dynamic Image-Based Rendering》的论文中,谷歌和康奈尔大学的研究人员提出了一种全新的方法,而它可以扩展到长持续时间,无界场景,不受控camera路径,以及具有快速而复杂对象运动的动态视频。

......(全文 1709 字,剩余 1302 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限