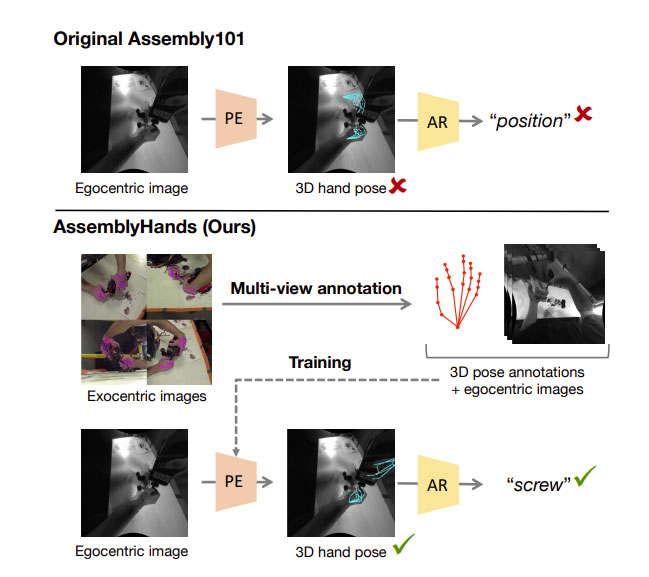

Meta研究员:3D手部姿态质量显著影响动作识别性能

自中心手部姿态数据集

(映维网Nweon 2023年06月20日)识别人类活动是计算机视觉领域的一个重要课题。随着增强现实和虚拟现实系统的进步,从自中心(第一人称)角度识别动作的需求越来越大。诸如微软HoloLens、Magic Leap和Meta Quest等设备通常配备了自中心摄像头,以捕获用户与真实世界或虚拟世界的交互。

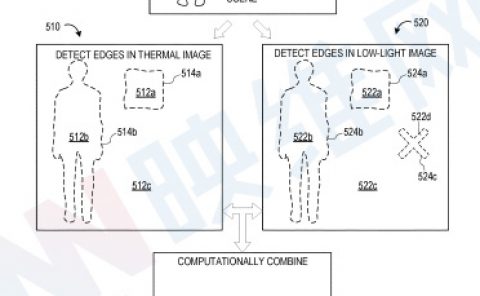

在这种场景中,用户通过双手操纵对象是一种非常重要的交互方式。特别是,手的姿态在理解和实现手-物交互、基于姿态的动作识别和交互界面中起着核心作用。社区已经提出了数个用于理解自中心活动的大规模数据集,如EPICKITCHENS、Ego4D和Assembly101。特别是,Assembly101强调了3D手在识别程序性活动的重要性,例如组装玩具。

值得注意的是,Assembly101的作者发现,对于组装动作的分类,从3D手部姿态中学习比仅仅使用视频特征更有效。然而,所述研究的一个缺点是,Assembly101中的3D手部姿态注释并不总是准确,因为它们是从现成的自中心手部追踪器计算出来的。如图1可以观察到,提供的姿态往往是不准确,特别是当手被物体遮挡时。

......(全文 4670 字,剩余 4303 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限