Meta研究员探索立体视觉动态深度问题,提高视频数据立体重建的时间一致性

估计深度

(映维网Nweon 2023年04月28日)从立体视觉中估计深度是一个基本的计算机视觉问题,在3D重建和AR/VR等方面都有应用。随着多摄像头设备的出现,立体视觉可以简化日常场景的3D重建,将其提取为在虚拟现实或混合现实中体验的内容。

来自立体视觉的深度以从不同视点捕捉同一场景的两个图像作为输入。然后,它找到成对的匹配点,这个问题称为视差估计。由于两个摄像头经过校准,因此可以使用三角测量将匹配的点投影到3D中。

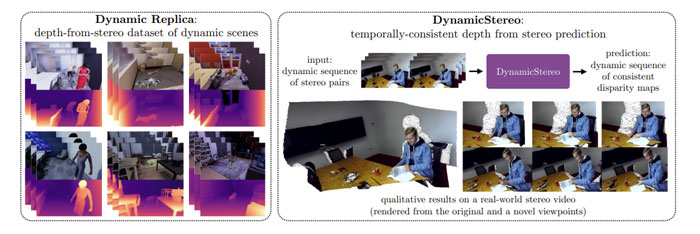

尽管这个过程很健定,但当应用于视频数据时,它是次优的,因为它只能单独重建立体帧,并会导致不一致。所以在名为《DynamicStereo: Consistent Dynamic Depth from Stereo Videos》的论文中,Meta和牛津大学的研究人员考虑了立体视觉的动态深度问题,以提高视频数据立体重建的时间一致性。

传统的立体视觉计算方法计算局部图像patch之间的匹配成本,将成本聚合到目标函数中,并将后者与正则化项一起优化以推断差异。这种方法的例子包括max-flow和graph-cut。近来,立体视觉方法使用了从大量用真实差异注释的图像对中学习的深度网络。

它们通常采用类传统方法,但使用深度CNN特征来计算匹配成本,并用预先训练的回归深度网络代替每张图像的优化,处理成本量并输出估计的差异。在视频设置中,通过在空间和时间上寻找匹配,可以隐式提高匹配质量。

......(全文 1856 字,剩余 1375 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限