Meta探索Avatar运动稀疏关键帧姿势,改善物理上合理运动效果

即便给出了糟糕的输入姿势,它都可以产生物理上合理的运动

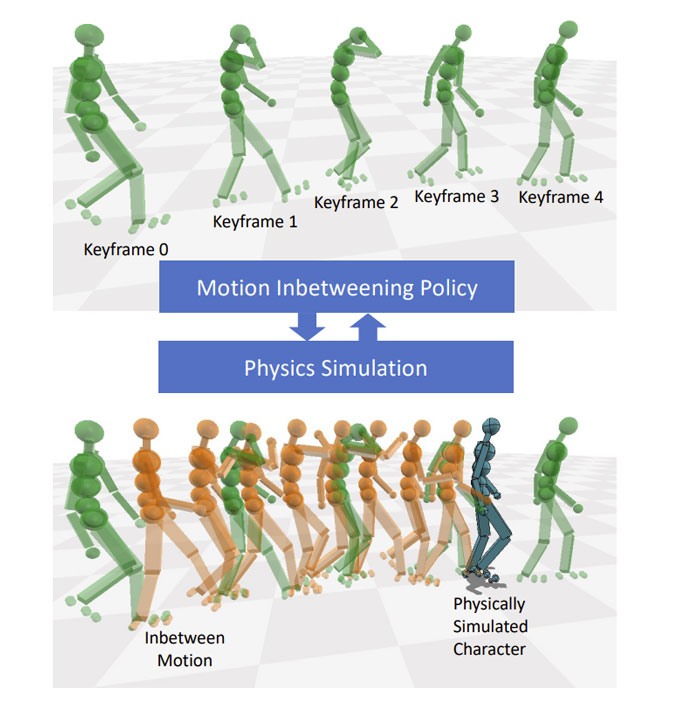

(映维网Nweon 2023年04月04日)为3D骨骼角色创建逼真人体运动是AR/VR等图形应用的重要过程之一。Motion in-betweening是创建骨骼动画的一种流行方法:美术提供时间粒度较小的关键帧姿势,而系统可以自动生成粒度更精细细的中间姿势。当关键帧姿态在时间上足够接近时,简单的线性或样条插值可以产生平滑和合理的结果。但由于约束不足,随着它们变得越来越稀疏,插值就变得不再简单。

业界有人提出了稀疏关键帧姿势(例如超过1秒)的Motion in-betweening方法,通过使用现有的运动数据集并以有监督方式学习深度神经网络。一旦学习了模型,生成的中间姿态将属于训练数据的分布范围,如果使用足够大和高质量的数据,则有可能解决约束不足和自然度问题。

在《Motion In-betweening for Physically Simulated Characters》的论文中,Meta人工智能团队和韩国首尔大学展示了一种新方法来解决稀疏关键帧姿势的Motion in-betweening问题。

......(全文 1289 字,剩余 939 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限