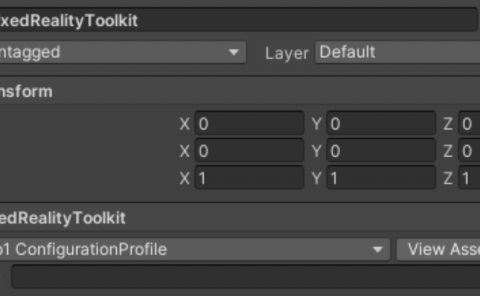

Unity发布XR Interaction Toolkit 2.3,全面支持关节式手部追踪

XRI 2.3

(映维网Nweon 2023年03月15日)Unity的XR Interaction Toolkit(XRI)是一个基于组件的high level交互系统,主要用于创建VR和AR体验。它为交互提供了一个通用框架,并简化了跨平台的创建。新发布的XRI 2.3版本增加了三个关键功能:

- 用于实现更自然交互的眼动追踪和手部追踪互

- 令交互变得更为生动的视听可供性

- 以及改进的设备模拟器

值得一提的是,XR开发者兼LearnXR.io创始人迪尔默·瓦莱西洛斯(Dilmer Valecillos)发布了一个XRI 2.3视频教程:而下面我们将介绍XRI 2.3的主要亮点:

全面支持关节式手部追踪

与XRI 2.3一起,Unity在预发行版中提供了XR Hands package。XR Hands是一个新的XR子系统,它添加了支持手部追踪的API。它包括OpenXR的内置支持,不久将支持Meta平台。另外,第三方硬件提供商可以通过API文档,从现有XR SDK中获取实时追踪数据。

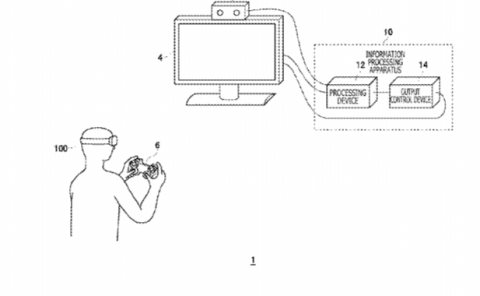

XRI的这一版本包括Hands Interaction Demo。这个展示手部交互设置的示例包允许你在裸手交互和控制器之间切换,无需更改设备场景中的任何内容。使用所述功能,你的内容可以从标准控制器设置开始,但可以无缝过渡到特定任务或游戏中的自然交互。

XRI 2.3同时支持通过XR Poke Interactitor进行的自然点戳交互。这允许你在3D UI或启用XRI的UGUI画布元素使用裸手或控制器进行点戳。

使用眼睛注视进行交互

像微软HoloLens 2、Meta Quest Pro和PSVR 2这样的新头显包括可以追踪用户视线的传感器。基于注视的交互可以帮助你构建感觉更自然的XR应用程序,并提供一种与内容交互的额外方式。为了支持这种类型的交互,Unity引入了由眼睛注视或头部姿势驱动的XR Gaze Interactor。你可以使用这个交互器进行直接操作。

由于Unity通常不建议应用程序完全由眼睛控制,所以团队提供了一种额外的控制器和基于手部的交互辅助形式,从而帮助用户选择特定对象:XR Interactible Snap Volume。这个组件可以作为XR Gaze Interactor的补充,因为它允许在瞄准对象周围的定义区域时将交互锁定至附近的可交互对象。Snap Volume同时可以在没有Gaze Interactor的情况下使用,以便用户更容易地选择对象。

视听可供性

使用裸手进行交互与使用控制器不同,因为没有触觉反馈来确认交互何时发生。可供性系统可以根据对象的交互状态动画化对象动或触发声音效果,从而帮助缓解这种反馈差距。

用双手拉伸、摆动和旋转

新的XR General Grab Transformer降低了层次结构的复杂性,并允许一个通用Transformer在可交互平台支持单手和双手交互,而不是多个Grab Transformer。它同时支持双手缩放,允许你通过移动双手来上下缩放对象。

Unity同时添加了一个Interaction Group组件,从而允许开发人员将interactor分组,并按优先级对其进行排序,这使得每个组在给定时间只能有一个interactor进行交互。例如,当Poke、Direct和Ray interactor组合在一起时,点戳一个按钮将暂时阻止其他interactor与场景交互。

无头显XR迭代变得更容易

在头显测试XR应用程序很重要,但在编辑器中测试有助于减少迭代时间。在这个版本中,团队优化了XR Device Simulator,其中包括一个新的屏幕UI小组件,从而允许你更容易地查看哪些输入驱动模拟器,哪些输入当前处于活动状态。

Unity同时添加了新的模拟模式,以便你可以在常用的控制模式之间切换。在启动时,设 XR Device Simulator激活新的第一人称射击(FPS)模式,并操作头显和两个控制器。然后,你可以在其他模式中循环操作各个设备:头显、左控制器和右控制器。要使用 XR Device Simulator,请从Package Manager导入示例。

新的XRI示例项目

Unity提供了新的示例项目,并用于展示了你可以在XRI 2.3中使用的一系列XR体验构建模块。你可以访问GitHub的示例项目,并使用它开启下一个XR应用程序。

展望未来

尽管眼手操作依然处于早期阶段,但Unity正在努力优化体验。随着迈向XRI 2.4及以上版本,团队将继续根据用户反馈来改进工具。