显示专家Guttag CES分享:VoxelSensors的AR/VR传感器技术

3D感知技术

(映维网Nweon 2023年02月06日)近眼显示技术专家卡尔·古塔格(Karl Guttag)正继续分享自己的CES之旅。本次的分析对象是VoxelSensors。

延伸阅读:显示专家Guttag CES分享:Meta Materials的突破性调光技术

延伸阅读:显示专家Guttag CES分享:Porotech的先进Micro LED技术

延伸阅读:显示专家Guttag CES分享:Addoptics的3D可打印光学模具

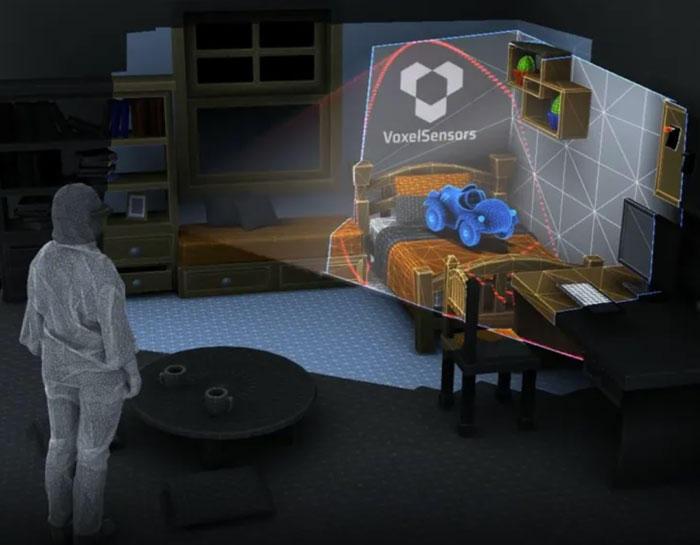

VoxelSensors专注于研发旨在融合物理世界和数字世界的传感器技术。这家公司的产品提供的解决方案主要应对互联网新时代的3D感知挑战,通过低功耗、低延迟和低复杂度的传感技术来将物理和数字世界与新型3D感知解决方案相结合。

引言

我的CES 2023博文系列是从AR/MR的基础技术开始,而不是实际产品,比如说Meta Materials的非偏振调光技术,Porotech的MicroLED显示技术,以及Addoptics的3D可打印光学模具。本文讨论了VoxelSensors及其全新的3D感知技术。

尽管我熟悉3D感知的基本概念,但我并没有对其进行广泛的研究。所以,我在术语方面可能会犯错,并且没有意识到用于AR和VR的特定方法。据我所知,VoxelSensors似乎比当前的3D感知方法有了重大进步。

为了帮助理解VoxelSensors方法的不同,本文结尾简要介绍了常见的现有3D感知方法及其局限性。

Voxelsensors的Switching Pixels:一种新型“摄像头”

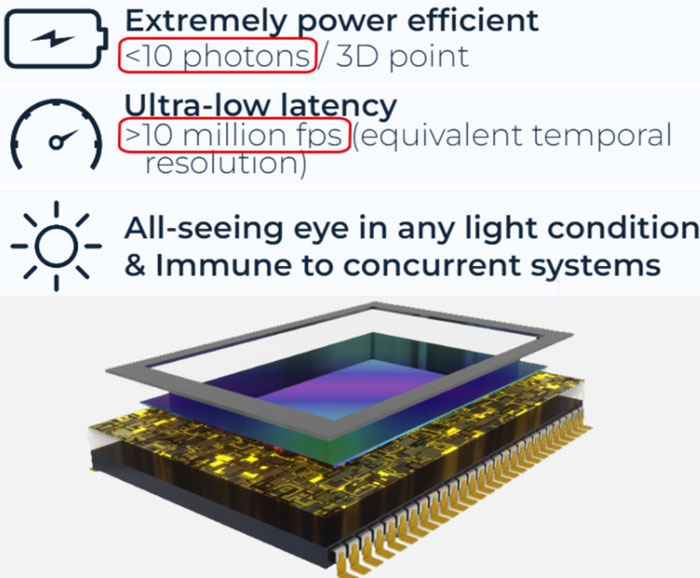

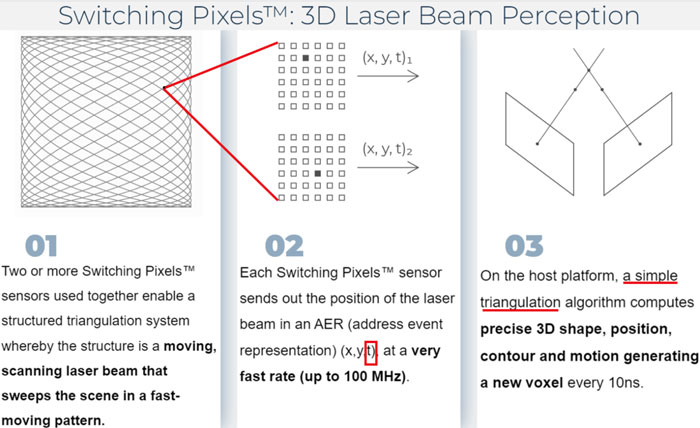

据介绍,VoxelSensors专有的Switching Pixels是一种传感器架构,设计用于基于激光束扫描的3D感知。它定位空间中的有源激光点或结构,而输出则用于以100 MHz的速率生成3D点(体素)。

VoxelSensors的工作方式与众所周知的“Event Camera”不同。但在团队开发出专门的和性能更好的产品之前,他们将Event Camera用于开发算法。

因为VoxelSensors设计用于寻找扫描激光,所以它可以对激光非常敏感,同时拒绝所有其他光。由于激光和红外辐射对眼睛的安全限制,在3D感知中,更好的传感器灵敏度将转化为更好的感知范围和分辨率。

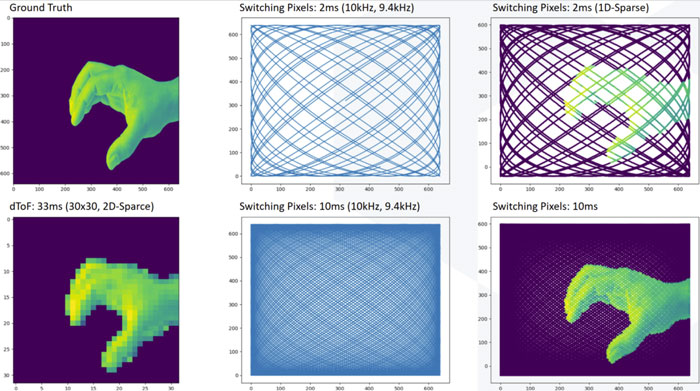

VoxelSensors的3D感知方法

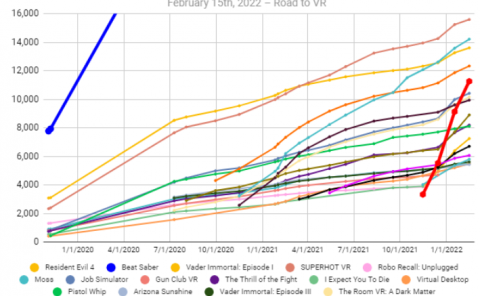

VoxelSensors的3D感知方法从Lissajous扫描开始。尽管扫描不必是Lissajous扫描,但Lissajous可以快速扫描整个区域的空间图像。如果在扫描过程中一切都是静止的,分辨率会不断提高。就概念而言,高分辨率感知是根据一系列最新的稀疏检测建立。下图说明了稀疏扫描过程是如何比普通的飞行时间摄像头和LiDAR实现更快的检测。请注意,它在任何时间点都会有更高分辨率的图像。

比典型的LiDAR检测速度快10倍以上

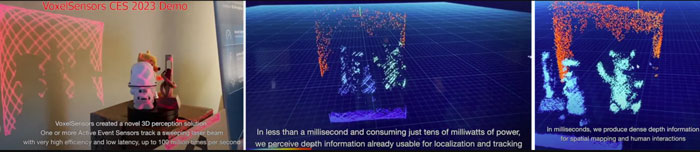

VoxelSensors的方法可以在不到1毫秒的时间内获得整个视场的稀疏图像。相比之下,典型的LiDAR方法可能需要16毫秒或更长时间,外加在检测到任何东西之前所需的处理时间。

使用两个VoxelSensors的输出,通过简单的三角测量来确定3D距离非常简单,不需要复杂的图像处理。与LiDAR不同,距离精度不是基于光速。所以,距离分辨率可以更高,并且不需要基于光速测量距离所需的校准程度。下图概述了VoxelSensors的3D感知过程。

VoxelSensors制作了一段1分钟的视频来展示了他们的套件以及技术信息。他们使用了可见的红色激光(而不是红外),这样我们就能看到相关过程。

视频中的设备又大又笨重,所以在整合至AR或VR头显方面尚有很长一段路要走。但这在早期演示中十分常见。

使用Oqmented的Lissajous扫描仪

VoxelSensors正在努力实现小型化,而团队于2022年12月宣布与生产Lissajous扫描仪的Oqmented合作。除了3D感知,Oqmented近几年来一直在尝试将他们的Lissajous扫描工艺用于制造激光扫描显示器。

我曾经在博文中指出,Lissajous扫描激光束扫描显示器没有任何意义或竞争力。但在同一篇文章中,我认为Oqmented和使用Lissajous扫描的3D传感将在3D传感方面具有巨大意义。坦率地说,Oqmented应该专注于感知技术,并放弃显示器应用。

背景:常见的AR/VR 3D感知方法

3D感知的基本目标是根据现实世界中的物理对象的水平(X)、垂直(Y)和深度(Z)来发展体素点云。VR/AR中使用的常见3D感知技术包括:

- 光学(可见光和红外)追踪:来自一个或多个摄像头的图像与图像处理和结构假设(如手指与手的关系和手与手臂的关系)相结合,从而确定2D和3D位置。随着时间的推移,使用多个摄像头或多个帧可以从图像中提取深度信息。

- 尽管这是获得某种程度的3D感知的最常见和成本最低的方法,但分辨率和精度(特别是Z/深度)很低,需要大量的处理。

- 速度受到摄像头帧速率和处理图像时间的限制。任何深度感测都很慢,可能需要多帧才能构建。

- 结构光:投影一个或多个(通常为红外)光图案,然后由一个或更多个(通常是红外)摄像头捕获。接下来,处理结构光图案的失真以提取3D信息。结构光最初因微软Kinect而出名。2013年,苹果收购了开发Kinect 3D感知技术的PrimeSense,并随后开始在iPhone和iPad添加结构光3D感知(从iPhone X开始)。

- 结构光通常在理解Z/距离方面更好,并且需要更少的处理。但如果只有一个投影仪和摄像头(例如iPhone X),有时需要移动投影仪和摄像头才能获得精度。

- LiDAR(使用一个飞行时间传感器进行扫描):它的工作原理是发出一束IR光,通常是激光,并测量光返回一个或几个传感器所需的时间,其中距离根据光速计算。沿X和Y扫描一个或多个脉冲光束以确定X和Y。X和Y位置通过与扫描处理同步来确定,Z/距离通过脉冲光源返回所需的光速来确定。光束可以通过多种方式进行扫描,包括MEMS扫描镜和振动衍射光栅。

- 固态飞行时间摄像头(ToF)/激光雷达(LiDAR):不是扫描窄(激光)光束,而是用单个宽光束或激光通过衍射光栅等发出较小光束阵列。一个带有小型X-Y阵列传感器的飞行时间摄像头用于测量时间,从而测量距离。固态LiDAR经常出现在手机、VR和AR系统中。

- 在任何给定的情况下,分辨率都限于ToF摄像头的分辨率(通过结合运动信息,可以随着时间的推移建立更高的分辨率)。

- 单个传感器通常需要更多的光子来感测,这意味着系统需要更多的时间。

- 时间测量的准确性

- AR/VR中的速度通常很慢。例如,Hololens 2可能需要一秒钟的时间来确定远距离。

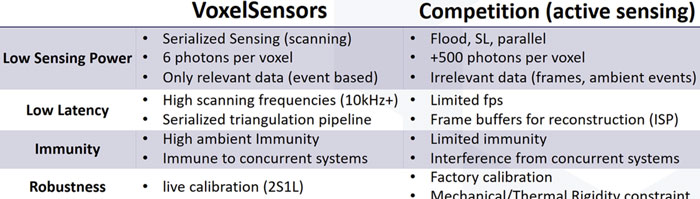

下表是VoxelSensors进行的比较:

结论/总结

我认为VoxelSensors相对于现有3D感知方法的主要突出功能包括:

- 更快的运动初始检测(约1毫秒,而其他通常为16-33毫秒)

- 用于深度计算的简单三角测量 vs 光速测量或大规模立体图像处理,其在计算精度和速度(以及功率)方面具有优势。

- 高灵敏度的Switching Pixels实现更高的帧速率、更长的距离和更好地利用眼睛安全的激光。

当然,我们需要继续耐心等待VoxelSensors系统将如何小型化,以及Switching Pixels的生产成本。我认为VoxelSensors最终将在尺寸和成本方面与飞行时间摄像头竞争,但同时提供上述优势。