Meta发布多个示例展示Quest Movement SDK身体追踪灵活性

四个示例场景

(映维网Nweon 2022年11月21日)无论是射击目标、在扑克桌与他人聊天,还是完成训练,自然流畅的运动表现都是大多数沉浸式VR体验的核心。通过Presence Platform的Movement SDK,你可以通过全新的身体追踪、面部追踪和眼动追踪等功能打造更深入的临场感。

日前,Meta在Github发布了全新的示例,从而向你展示Movement SDK在不同用例中的灵活性。

团队共发布了四个场景,包括:

- “Aura”:一个幻想外星人角色,用于展示面部追踪能力。

- High Fidelity:一个高保真度角色,演示了如何在3A游戏体验中使用身体追踪和面部追踪。

- Hip-pinning:演示了身体追踪如何与虚拟对象真实交互。

- Retargeting:演示了如何从三点式身体追踪中获取动作,并将其映射到任意人形角色模型。

Movement SDK由眼动追踪、面部追踪和三点身体追踪功能组成,而它们将有助于解锁全新的临场维度。Movement SDK允许Avatar使用Quest Pro的朝内传感器实时模拟面部动作。现在,开发者可以通过眼动追踪和面部追踪实现栩栩如生的Avatar,从而令虚拟角色可以看起来和感觉更像真人。值得一提的是,这是驱动Horizon Worlds和Holizon Workrooms中的Avatar的相同底层技术。

眼动追踪和面部追踪功能

Movement SDK包括Quest Pro新开发的眼动追踪和面部追踪功能。头显内有五个指向面部的红外传感器:三个指向眼睛和上半脸,两个指向下半脸。面部追踪由机器学习模型驱动,可允许Quest Pro检测各种面部运动。

Movement SDK输出的抽象面部运动数据由基于面部动作编码系统Facial Action Coding System(FACS)的线性混合形状表示。FACS是一系列0到1的值,与一组通用面部运动相对应,例如皱眉。在将信号从Face Tracking API 映射到自己的角色rig时,开发者可以轻松保留用户原始动作的语义含义。

随着Movement SDK的引入,Meta现在能够支持第三方角色具现的社交临在。例如,团队创建了一个称之为Aura的外星人角色。她可以眨眼,左右移动嘴巴等等。

正如你在上面视频所示,Aura的面部和眼部动作可用于社交活动,并展示了机器学习驱动的高分辨率角色的潜力。Aura将于本月中下旬作为可下载示例托管至GitHub。你可以自由查看幕后情况,看看Meta是如何实现重定目标和rig映射。届时可注意相关的文档,它将为映射到不同的具体角色提供指导和最佳实践。

除了社交临在之外,开发者同时可以估计某人在VR中的视线作为输入,从而构建全新的交互和体验,类似于手动追踪。这意味着人们可以根据自己的视线所见来与虚拟内容进行交互。

Meta表示,他们从一开始就把隐私问题纳入了考虑范围。应用程序永远无法通过所述功能访问用户眼睛和脸的原始图像数据(或图片),它们只能通过一组数字来估计人们在VR中的注视位置和面部运动。开发者和Meta无法访问人们的眼睛和面部图像,因为它们在处理后会被删除,并且永远不会离开头显本地。

这家公司表示:“我们非常期待开发者使用眼动追踪和面部追踪来提高VR社交体验的创造性方法。”

Body Tracking API

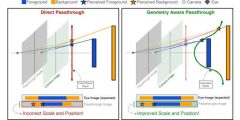

Movement SDK同时包括Body Tracking API,后者可根据控制器或手相对于头显的位置来使用三点追踪。肢体语言是社交体验的一个重要组成环节。若看到角色的身体动作不符合人类实际,这将会完全打破沉浸感。所以,Meta使用了大量真实人体运动数据集来学习和纠正简单反向运动学(IK)方法常见的错误。

Body Tracking API可以在玩家使用控制器或仅使用裸手的情况下工作,并且在这两种情况下都提供了完整的模拟上身骨骼。它同时可以自动处理玩家放下控制器并开始使用裸手的情况,无需开发者进行任何额外的逻辑处理。

Body Tracking API适用于Quest Pro和 Quest2,并会支持未来的Meta Quess设备。另外,未来几年的Body Tracking API优化将通过相同的API实现,因此你将能继续从Meta获得最佳的身体追踪技术,无需切换到不同的界面。

Movement SDK现在已经可用,所以你可以马上开始构建利用所述新功能的应用程序。SDK信息请访问这个页面,新的示例场景请访问Github。