Quest Movement SDK通过IK反向运动学为Avatar提供全身效果

Movement SDK已于日前正式与大家见面

(映维网Nweon 2022年10月26日)包含眼动追踪和面部追踪功能的Movement SDK已于日前正式与大家见面,而Meta官方Twitter账号表示,现在你可以通过“身体追踪,面部追踪和眼动追踪把用户的物理运动带到元宇宙,并提升社交体验”。

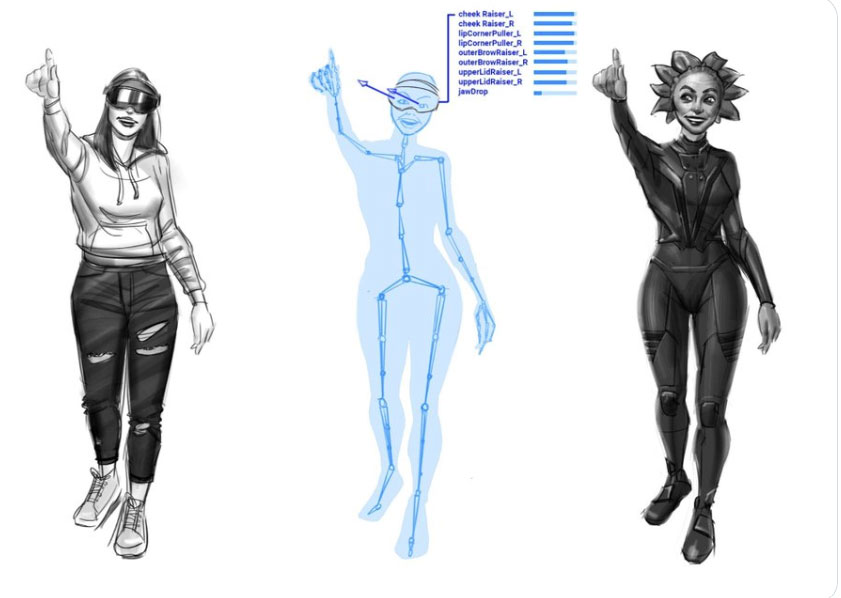

利用Movement SDK,开发者现在可以为应用带来栩栩如生的Avatar,甚至是包括基于机器学习和IK反向运动学推导出来的下半身。

Movement SDK包括Quest Pro新开发的眼动追踪和面部追踪功能。头显内有五个指向面部的红外传感器:三个指向眼睛和上半脸,两个指向下半脸。面部追踪由机器学习模型驱动,可允许Quest Pro检测各种面部运动。

Movement SDK输出的抽象面部运动数据由基于面部动作编码系统Facial Action Coding System(FACS)的线性混合形状表示。FACS是一系列0到1的值,与一组通用面部运动相对应,例如皱眉。在将信号从Face Tracking API 映射到自己的角色rig时,开发者可以轻松保留用户原始动作的语义含义。

Movement SDK同时包括Body Tracking API,后者可根据控制器或手相对于头显的位置来使用三点追踪,并利用IK反向运动学和机器学习来进行全身姿势估计,使用了大量真实人体运动数据集来学习和纠正简单IK方法常见的错误。

作为说明,正向运动学(Forward kinematics, FK)利用机器人运动学方程,根据关节的特定参数计算末端受动器(end effector)的位置。正向运动学要求用户为所有涉及的关节设置参数。

反向运动学(Inverse kinematics, IK)的流程则与FK相反。它是利用机器人运动学方程来确定机械手的关节参数。末端受动器可以是关节,不一定位于末端。IK可以允许你根据已知位置估计骨架的未知部分。换句话说,Quest可以根据获取的身体位置来推断无法追踪覆盖的位置,例如下半身。

Body Tracking API可以在玩家使用控制器或仅使用裸手的情况下工作,并且在这两种情况下都提供了完整的模拟上身骨骼。它同时可以自动处理玩家放下控制器并开始使用裸手的情况,无需开发者进行任何额外的逻辑处理。

Movement SDK现在已经可用,所以你可以马上开始构建利用所述新功能的应用程序。