谷歌研究为NeRF渲染提出视图合成深度学习模型

视图合成深度学习模型

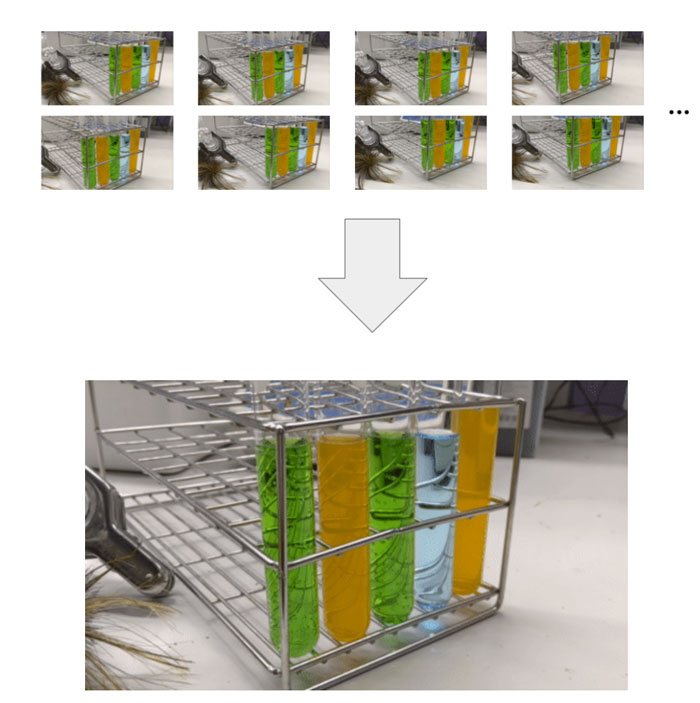

(映维网Nweon 2022年10月05日)视图合成是计算机视觉和计算机图形学的一个长期问题,其目标是从场景的多张图片中创建新的场景视图。自从引入神经辐射场(NeRF)以来,这一点受到了越来越多的关注。这个问题非常有挑战性,因为若要准确地合成场景的新视图,模型需要从一小组参考图像中捕获多种类型的信息,包括详细的3D结构、材质和照明。

在日前一篇博文中,谷歌介绍了最近发布的视图合成深度学习模型。在CVPR 2022大会介绍的LFNR光场神经网络渲染中,谷歌通过使用学习组合参考像素颜色的transformer来解决精确再现视图相关效果的挑战。然后,在ECCV 2022大会介绍的GPNR中,谷歌通过使用一系列具有规范化位置编码的transformer来解决泛化到未知场景的挑战。

其中,transformer可以在一组场景进行训练,并合成新场景的视图。所述模型执行基于图像的渲染,结合参考图像的颜色和特征来渲染新视图。它们完全基于transformer,在图像patch集上操作,并利用4D光场表示进行位置编码,这有助于建模视图相关的效果。

......(全文 1430 字,剩余 1052 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限