微软发布预训练的类人控制模型库MoCapAct,助力人工仿人控制的高级研究

发布了一个预训练的类人控制模型库MoCapAct

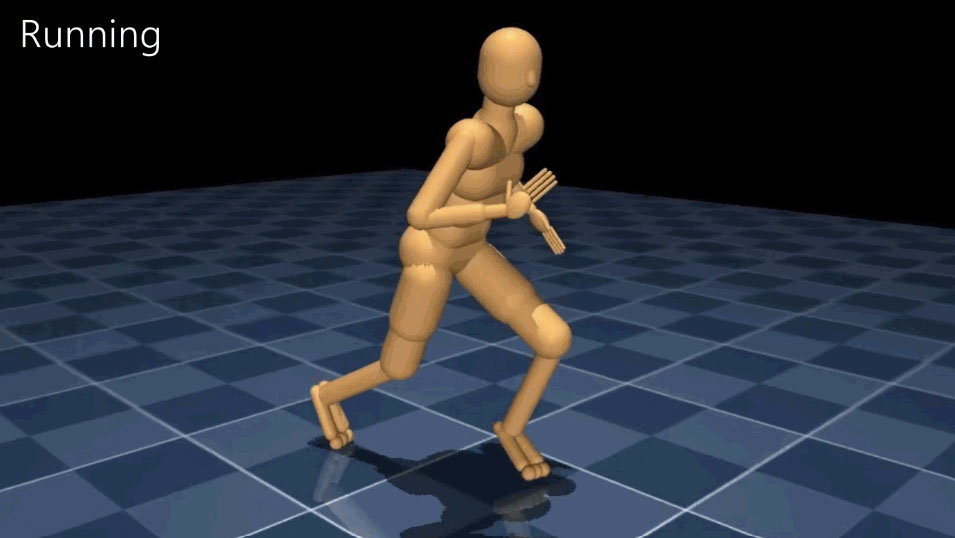

(映维网Nweon 2022年09月05日)要令两足人形机器人像摇滚歌手米克·贾格尔一样跳舞需要什么?实际上,即便是令它们简单地站起来,自由行走,或者以其他我们认为理所当然的方式移动都是一个挑战。

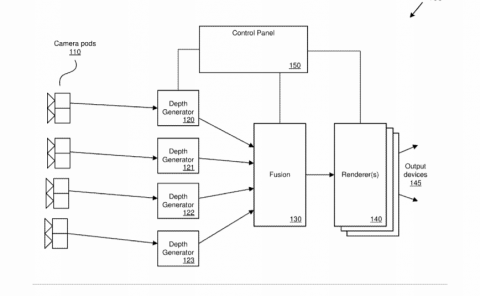

为了帮助社区实现仿人控制的高级研究,微软和佐治亚理工学院日前发布了一个预训练的类人控制模型库MoCapAct,从而允许研究人员以传统方法所需计算资源的一小部分来实现人工仿人控制的高级研究。

在为人类设计的环境中,两足行走提供了无与伦比的多功能性。通过混合和匹配广泛的基本运动技能,从步行到跳跃到单脚平衡,人们可以跳舞、踢球、以及进行其他复杂的高水平运动。如果机器人要充分发挥其作为辅助技术的潜力,掌握各种两足运动是一项重要要求。

......(全文 2061 字,剩余 1759 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限