普林斯顿大学用AI神经网络从视频中对动物展开动作捕捉

文章相关引用及参考:princeton

这是一个灵活的工具,原则上可用于任何视频数据

(映维网 2018年12月24日)你可能见过好莱坞明星身穿的动捕套装的样子,而计算机可以利用相应的传感器信息来将他们的表演转换成绿巨人或智慧猿人。

现在,普林斯顿教授Mala Murthy和Joshua Shaevitz的联手合作则更进一步,利用人工智能的最新进步来追踪动物的身体运动。

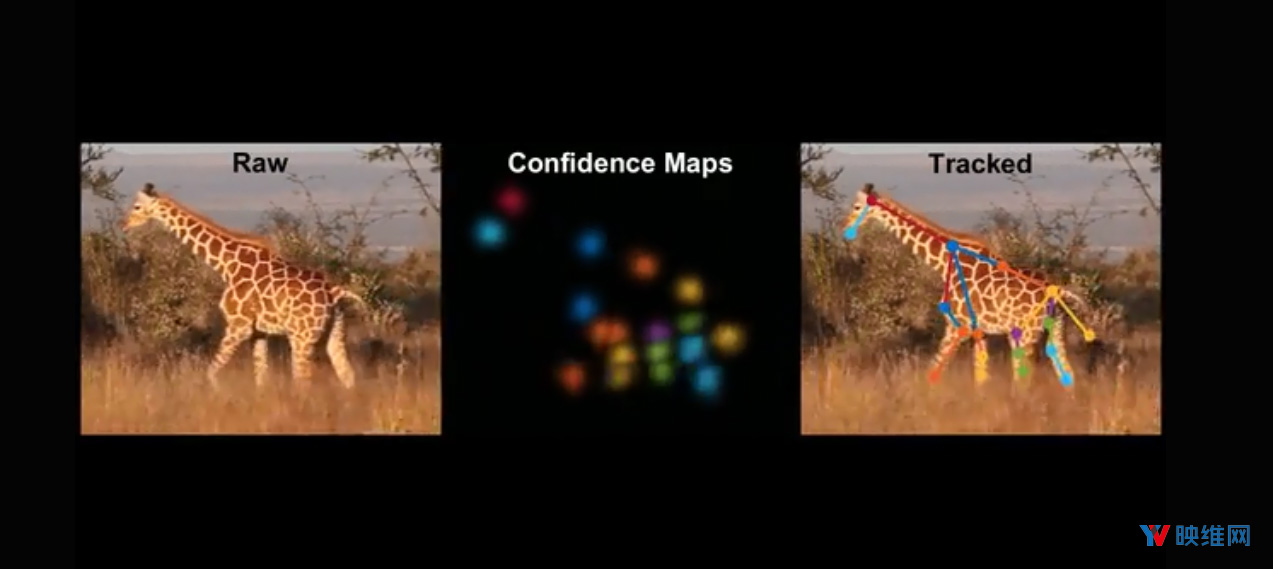

只需数分钟,他们研发的工具LEAP Estimates Animal Pose(LEAP)就能够以高精度自动追踪数百万帧视频中的各个动物身体部位,无需添加任何物理标记或标签。

详细介绍这项新技术的论文将发表在2019年1月出版的《Nature Methods》期刊上,但他们于5月推出的公开访问版本已经促使其他一系列的实验室采用了他们的软件。

相关论文:Fast animal pose estimation using deep neural networks

......(全文 811 字,剩余 546 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限