Meta提出基于XR眼动追踪的自适应透视渲染技术

由眼动追踪辅助的透视渲染方法

(映维网Nweon 2025年10月20日)对于XR头显的透视图,一般是通过使用场景的深度测量,将摄像头捕获的图像重新投影或扭曲到用户的眼睛位置,从而生成透视图像。由于重投影依赖于物理场景的深度信息,所以深度表示(例如深度网格)的准确性起着重要作用。但在实践中,为整个可见场景实时生成像素精度的深度表示十分困难。高分辨率和准确的深度传感不仅具有挑战性,而且需要足够强大以适应不同的照明条件,物体运动,头部运动,遮挡和其他环境因素。另外,从捕获的深度信息生成场景的深度表示可能在计算方面十分昂贵。同时,深度传感和深度表示的生成需要在严格的时间限制、有限的功率预算和更高的精度要求下实现。所以,设计一种合适的技术来生成透视渲染的深度表示,对开发人员和研究人员来说是一个复杂的挑战。

在一份专利申请中,Meta就介绍了由眼动追踪辅助的透视渲染方法。

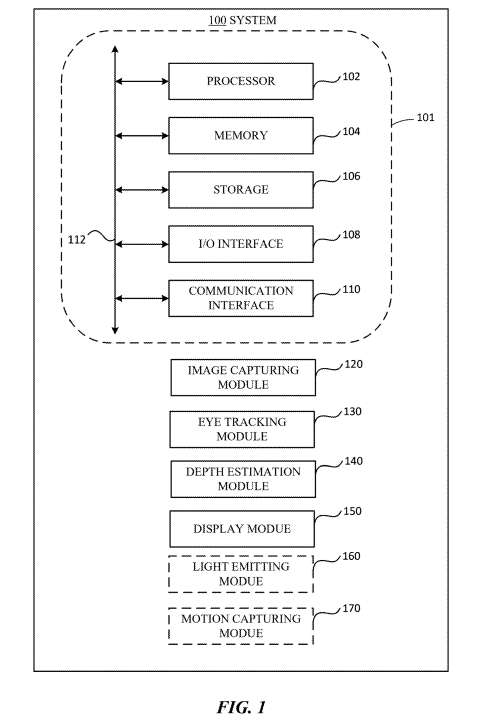

图1示出了一个基于捕获的图像数据和确定的深度网格向用户渲染场景的示例系统100。系统100包括计算设备101,该计算设备包括处理器102、存储器104、存储设备106、输入/输出(I/O)接口108、通信接口110和总线112。另外,系统100包括图像捕获模块120、眼动追踪模块130、深度估计模块140、显示模块150,以及可选的发光模块160和动捕模块170。

......(全文 7429 字,剩余 6958 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限