Meta 首席科学家分享:情境式AI与人机交互未来

首席科学家迈克尔·亚伯拉什

(映维网Nweon 2025年09月19日)当登台协助为第二天的主题演讲收官时,Reality Labs首席科学家迈克尔·亚伯拉什回顾了他在2016年Connect大会做出的预测,并反思了我们迄今在虚拟现实和增强现实领域取得的进展。

他表示:“过去九年再次印证了霍夫斯塔特定律。即便你考虑了霍夫斯塔特定律,事情花费的时间总是会超出预期。”

虽然尚未量产,但Meta在触觉技术、照片级虚拟形象、视野范围等领域已实现关键突破。Meta Quest和Orion原型机都在将数字内容与现实世界视野相融合。亚伯拉什说道:“九年前我描绘的未来正在到来,只是比预期更晚些。”

超出预期的是情境式AI的出现——除了少数远见者的想象外,无人预料到这种能理解物理世界及人类所处位置的AI。

与仅从互联网信息中学习的大型语言模型(LLM)和生成式AI不同,情境式AI能看见我们所见的,听见我们所闻的,并实时理解我们所处的环境。

亚伯拉什解释道:“这确实是前所未有的创新。它将彻底改变我们与数字世界的交互方式,让人与计算机、人与人形成伙伴关系,以真正个性化、人性化的方式极大释放人类潜能。”

要理解亚伯拉什早在2018年就预言将以AR和VR形式出现的第二次人本计算浪潮,有必要先了解标志人机交互范式革命、造就当今互联信息设备世界的第一次浪潮。

第一次人本计算浪潮时间轴

1957年//J.C.R.”利克”·利克利德在MIT林肯实验室邂逅实验型TX-2计算机

“希望在不远的未来,人脑与计算机能紧密耦合,这种伙伴关系将实现前所未有的思考方式,以当今信息处理机器无法企及的方式处理数据。”——J.C.R.利克利德

1960年代//利克利德在ARPA资助包括道格拉斯·恩格尔巴特在内的多位研究者

1968年//恩格尔巴特展示”所有演示之母”,呈现现代图形用户界面(GUI)雏形

“如果在办公室为你这位知识工作者配备终日待命的计算机显示系统,能即时响应你的每个操作——你将从中获得多大价值?”

——道格拉斯·恩格尔巴特

1970年代//施乐PARC研究中心开发出首台真正个人电脑Alto

1979年//苹果工程师造访施乐PARC,受Alto启发后开发Lisa和Macintosh系统

亚伯拉什指出:“这直接催生了Mac、Windows及后续所有产品。今天我们生活在利克和恩格尔巴特创造的世界——你们每个人都随身携带着利克愿景的直接产物,运行着恩格尔巴特界面的直系后裔。”

变革之海

亚伯拉什表示:“第一次浪潮是我们徜徉的海洋。但尽管这场革命席卷全球,它仍未完成。”

亚伯拉什强调,我们对世界的体验取决于感官接收的信息以及行动产生的结果。这些信息来自何处或行动发生于何处并不重要:数字虚拟信息与行动与现实世界同样有效。

亚伯拉什解释道:“利克发起的革命创造了一个我们持续交互的庞大虚拟世界,但交互方式极其有限——仅通过二维平面上的应用,依靠点击、敲击和键入来操控。这固然被证明极具价值,但仅动用了我们手部与感官可用带宽的极小部分,因此只能提供我们所能体验与实现的有限子集。”

其结果是,计算设备不断索取注意力,将我们从当下情境与眼前之人抽离。

第二次人本计算浪潮将通过“以最高保真度驱动所有感官,同时让双手在虚拟空间自然移动并真实触感交互对象”来实现利克利德的愿景。亚伯拉什表示:“与物理现实完全无法区分的虚拟体验尚需时日,但我们已经能以逼真方式驱动视觉与听觉。随着技术演进,我们将能以更丰富的方式工作娱乐,实现真正人性化的远程连接。”

当然,人类体验不仅限于外部世界的关系——虽然重要,但定义我们之所以为人的是形成世界模型的内部认知过程。

亚伯拉什指出:“技术极大扩展了人类与外部世界交互的范围和能力,但几乎未触及我们的内部体验。尽管手机终日相伴,它却不理解我的情境、目标或决策过程,因此无法助力我的内部体验。若能实现,这将在提醒、听觉辅助、情境化讯息通话处理、强化记忆等方方面面革新我的生活。”

实践中的可能形态?以昨日发布的对话专注功能为例。手动开启时可助你在嘈杂环境中听清对话。若情境式AI知悉你的偏好,则会在你身处嘈杂环境尝试交谈时自动激活。当新朋友加入谈话,AI会同步放大其声音——无论你当时注视何处。这一切都将在你无意识间完成。

亚伯拉什坦言:“第一种场景已是极具价值的功能,我迫不及待想体验。但得益于理解我需求目标的AI,第二种场景才真正实现了听觉感知的完整进阶。”

试想AI能理解你周边的三维世界:帮你寻找钥匙,实时辅助记录卡路里,在会议中主动推送相关备忘,以近乎完美的清晰度追溯过往体验。你再也不会因需要手动辨别推销电话与母亲重要讯息而被打断当下时刻。

亚伯拉什说道:“可能存在数千种应用场景,或大或小,但共同点是让你以前所未有的深度实现人生追求。这种AI助你在需要时专注,记住该记之事,建立更有意义的连接,增强而非抽离你在现实世界的体验。”

得益于大型语言模型与可让AI共享视野的可穿戴设备,我们开启了技术新可能:放大人类意图而非分散注意力。将情境式AI视为帮你处理信息(物理或数字)并采取行动的伙伴。

亚伯拉什说说道:“若在十一年前,我会认为这些都是不切实际的科幻构想。但Ray-Ban Meta智能眼镜、大型语言模型与十年研究的结合,已使情境式AI成为人本计算的明确未来——第二次浪潮的核心。”

为深入阐述,他请出对此思考最久的先驱之一:研究科学副总裁理查德·纽科姆。

人类网络的局限与潜能

纽科姆首先带我们回到1968年:阿波罗8号任务中宇航员威廉·安德斯拍摄的首张人类摄制地球全彩照片。

纽科姆解释道:“这种世界观震撼而新颖,它超越世人既往认知。一个被国界政治分割的世界突然呈现为统一整体——在浩瀚太空中独特而珍贵…这助推了现代环保运动兴起,彻底改变了人们对共享世界的理解。”

个人计算的兴起恰逢全球共同思维新时代的黎明。但纽科姆指出存在局限——尤其是邓巴数字理论,认为人类只能维持150个稳定关系。

另一方面,若六度分隔理论成立,地球上任意两人仅通过四个中间人即可建立连接。

纽科姆说道:“数据令人震惊——网络覆盖呈指数级增长。仅80个层级就能连接所有现存人类与既有思想。我们接近庞大人类知识与思维能力的潜力惊人——邓巴数字与六度分隔既代表局限,也彰显潜能。”

第一次人本计算浪潮消弭了距离障碍,让亲友同事触手可及。互联网与搜索让我们近乎即时获取人类知识宝库。但仍有潜力待发掘。

纽科姆指出:“可以这样理解,以发展现代信息论闻名的美国数学家克劳德·香农曾计算每个英文单词约含7-10比特信息。按正常语速(每分钟150词)计算,每人每秒产生约10比特信息。想想看:人类历史上的每部法律、每封信件、每个突破——包括此刻我向你们传递的所有内容——都是通过比1990年代拨号调制解调器更窄的通信通道实现的。”

相比之下,纽科姆指出基于感官的现实意识体验每秒处理约10亿比特信息。他类比为当下接收处理4K视频流的WiFi。但当你尝试与他人分享体验时,又退回拨号网速水平。因此,我们的网络实则是人类认知的聚合工具。

纽科姆指出:“我们发明工具扩展个体能力——书籍延伸记忆,数学助力结构化推理,计算机处理信息,互联网突破距离限制。但只有通过人类网络,我们才能真正超越单一大脑阅读、存储、推理与表达的瓶颈。这些网络是我们实现大规模行动与变革的方式。”

情境式AI的崛起

站在AI时代的黎明,我们面对的技术能筛选、聚合并预测远超单一大脑处理极限的信息。纽科姆认为,其真正影响不在于自动化日常重复任务,而在于如何根本性改变人类网络动态。

他表示:“想象AI促成全人类流动连接网络,其能力堪比当今最佳组织,让个体获得整个公司的力量。想象这样的组织对我们每个人开放——释放接触数十亿心智的通道。我们正迈向让每个个体访问联邦式输入、聚合、处理、合成与输出系统的飞跃——这此前只有人类网络能通过时间过滤实现。”

然而当前大型语言模型存在局限。尽管经过互联网规模数据训练,它们仍缺乏对物理世界及人类体验的情境理解。

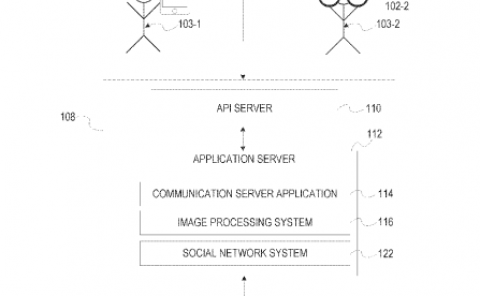

纽科姆表示:“情境式AI弥合了具身现实与符号认知世界间的鸿沟,使AI能理解我们共处的现实。这得益于能见你所见、听你所闻的AI智能眼镜。它们构成新一代可穿戴计算机,理解你的行为模式与协作方式。”

由于AI眼镜能共享你的视听体验,它们有望创建个性化知识库,使AI能根据重要事项定制交互与访问权限。长期来看,这不仅助于理解孤立事件,还能识别因果模式。

纽科姆解释道:“其潜力在于让AI理解互联生活如何编织成共享现实。一旦实现,AI就能直接基于我们持续的情境流来理解、预测并创造机会,让我们以最高效形式协作。这将使AI理解我们的关注重点与最优沟通方式——无论是与AI还是他人交互。”

真正的人性化界面

十余年来,Reality Labs持续推动虚拟与增强现实的技术前沿。Codec Avatars将打破距离限制,实现社交瞬移,让我们能像视频通话般轻松与任何地点的人真实共处。Meta通过Ray-Ban Meta智能眼镜向世界展示AI眼镜潜力。昨日发布的Meta Ray-Ban智能眼镜配备显示功能,通过全新Meta神经腕带实现视觉信息共享与无声超低摩擦输入。

纽科姆指出:“2020年首推、现已迭代至第二代的Aria项目,开启了情境化AI研发:结合传感与移动计算的研究眼镜为AI提供更优质情境。未来产品将逐步释放这些信号价值,包括理解我们的注视目标与完成意图。这些高度个性化的情境信号将催生高度个性化AI及所有衍生功能:帮助我们实现目标、共情、学习成长的超强记忆与回溯。随着AI眼镜逐渐在物理与数字生活中处理重要情境维度,超级智能将在我们的一切活动中扮演重要角色——无论是在物理还是数字现实,随时随地理解现实情境。”

Meta正在构建的技术有望释放集体潜能,基于共同认知创造理想现实。

他总结道:“当这些技术与真AR融合——沉浸式显示遇见情境式AI——我们将接近某种深远境界:不抽离现实而是增强体验与连接的界面。再没有比这更人性化的技术了。”