根特大学与邓迪大学联合提出极稀疏视角下360度场景新视角合成框架

从极稀疏输入视角实现360度场景的新视角合成

(映维网Nweon 2025年09月17日)从极稀疏输入视角实现360度场景的新视角合成对于虚拟现实和增强现实等应用至关重要。在一项研究中,比利时根特大学和英国邓迪大学团队提出一种针对极稀疏视角情况的新视角合成框架。

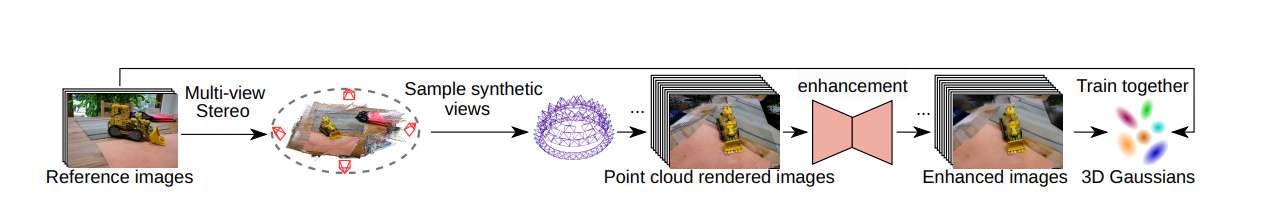

由于传统SfM方法在极稀疏视角下无法有效估计camera位姿,研究人员采用DUSt3R进行camera位姿估计并生成稠密点云。利用估计的camera位姿,从场景上半球空间密集采样额外视角,并结合点云渲染合成图像。通过将稀疏视角的参考图像与密集采样的合成图像相结合来训练3DGS模型,可扩大三维空间的场景覆盖范围,从而解决稀疏视角情况下因输入有限导致的过拟合问题。

基于自建数据集重训练扩散模型驱动的图像增强模型,并通过去除伪影进一步提升了点云渲染图像的质量。在仅使用四个输入视角的极端条件下,团队将所提出框架与基准方法进行比较,而结果表明其在360度场景的极稀疏视角新视角合成方面具有显著提升。

......(全文 1749 字,剩余 1376 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限