伦敦大学学院开发基于高斯飞溅的VR机器人远程操作系统

机器人+VR

(映维网Nweon 2025年08月04日)机器人领域已经开始利用虚拟现实来提高远程操作系统的精度和沉浸感,而这显著优于依赖2D摄像头输入和操纵杆控制的传统方法。尽管取得了进步,但挑战依然存在,特别是在不同设置的用户体验方面。

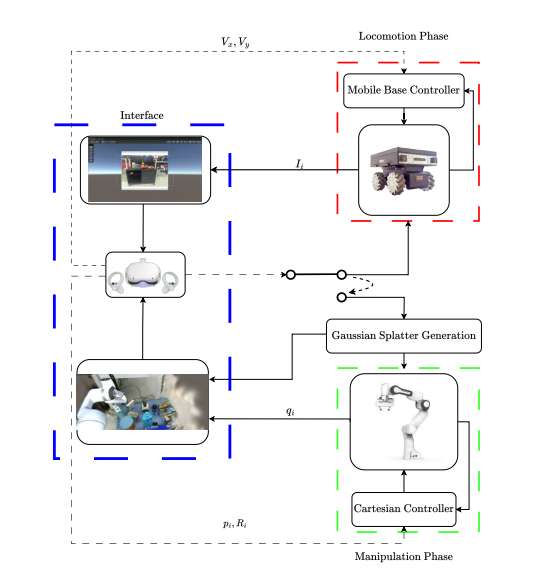

在一项研究中,伦敦大学学院团队介绍了一种基于虚拟现实技术的移动平台机器人远程操作框架。相关方法的核心是应用高斯飞溅,从而实现更直观和身临其境的交互。其中,用户可以在虚拟场景中导航和操作,就像与真实的机器人互动一样,以提高远程操作任务的参与度和效率。

广泛的用户研究验证了所提出方法,展示了显著的可用性和效率改进。三分之二(66%)的被试可以更快地完成任务,平均减少了43%的时间。另外,93%的受访者总体上更喜欢高斯飞溅接口,并一致(100%)推荐未来使用,突出了精度、响应能力和态势感知方面的改进。最后,团队通过两个不同应用场景的真实世界实验证明了框架的有效性,展示了基于高斯飞溅的VR界面的实用功能和多功能性。

......(全文 2647 字,剩余 2270 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限