英伟达发布VideoPanda模型 支持文本或单视图生成360度视频

一种基于文本或单视图视频数据合成360视频的新方法

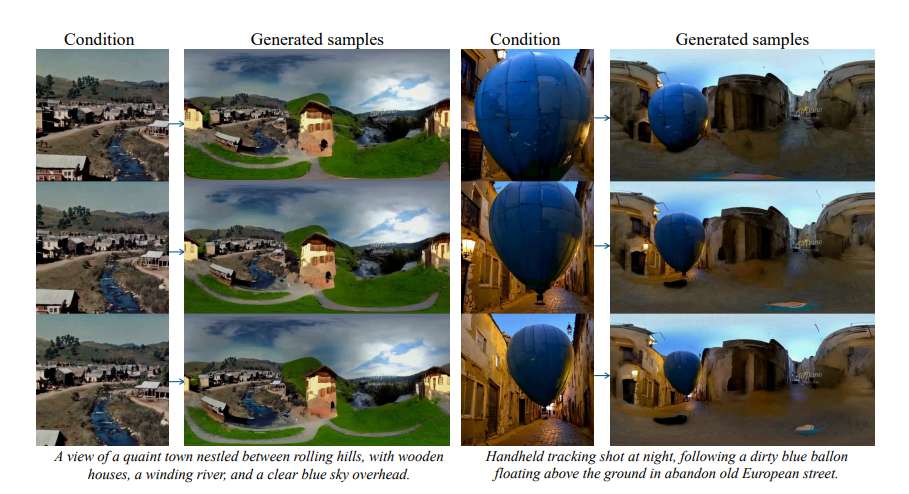

(映维网Nweon 2025年07月28日)高分辨率全景视频内容对于虚拟现实中的沉浸式体验至关重要,但收集起来并不容易,因为它需要专门的设备和复杂的摄像头设置。在一项研究中,英伟达团队介绍了VideoPanda,这是一种基于文本或单视图视频数据合成360视频的新方法。

VideoPanda利用多视图关注层来增强视频扩散模型,使其能够生成一致的多视图视频,并可以组合成沉浸式全景内容。VideoPanda采用纯文本和单视图视频两种条件联合训练,支持长视频的自回归生成。

为了克服多视点视频生成的计算负担,对训练过程中使用的持续时间和摄像头视图进行随机抽样,并表明模型能够在推理过程中出色地泛化到生成更多帧。对真实世界和合成视频数据集的广泛评估表明,与现有方法相比,VideoPanda在所有输入条件下生成的360度全景图更加逼真和连贯。

......(全文 2533 字,剩余 2205 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限