华南理工大学团队提出ROG框架提升VR人机交互真实感

人-物交互合成

(映维网Nweon 2025年07月04日)人-物交互(HOI)合成对于为虚拟现实等应用程序创建沉浸式和逼真的体验至关重要。现有的方法通常依赖于简化的对象表示,例如对象的质心或离人最近的点,以实现物理合理的运动。然而,相关方法可能忽略几何复杂性,导致次优的交互保真度。为了解决这一限制,华南理工大学,琶洲实验室和腾讯团队引入了一种基于扩散的框架ROG,通过丰富的几何细节对HOI中固有的时空关系进行建模。

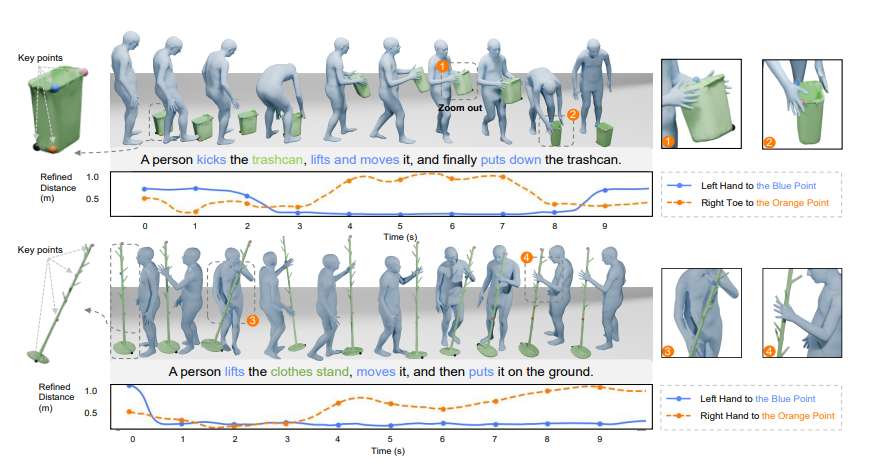

为了高效的对象表示,从对象网格中选择边界聚焦和精细细节关键点,确保对对象几何结构的全面描述。表示用于构建交互距离场(IDF),以捕获鲁棒HOI动态。另外,研究人员开发了一个基于扩散的关系模型,集成了空间和时间注意机制,从而更好地理解复杂的HOI关系。关系模型细化了生成运动的IDF,指导运动生成过程产生关系感知和语义对齐的运动。实验评估表明,ROG在合成HOI的真实感和语义准确性方面明显优于最先进的方法。

人-物交互(HOI)合成对于虚拟现实等应用创造身临其境的逼真体验至关重要。一个生动的HOI序列可能包括一系列涉及物体的动作,比如走路时拿起它,放下它,然后用脚调整它的位置,其中人与物体的运动应该同步,接触点必须精确。

......(全文 1639 字,剩余 1182 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限