腾讯+上交大团队提出音频驱动的多情感3D面部动画生成方法

音频驱动的情感3D面部动画

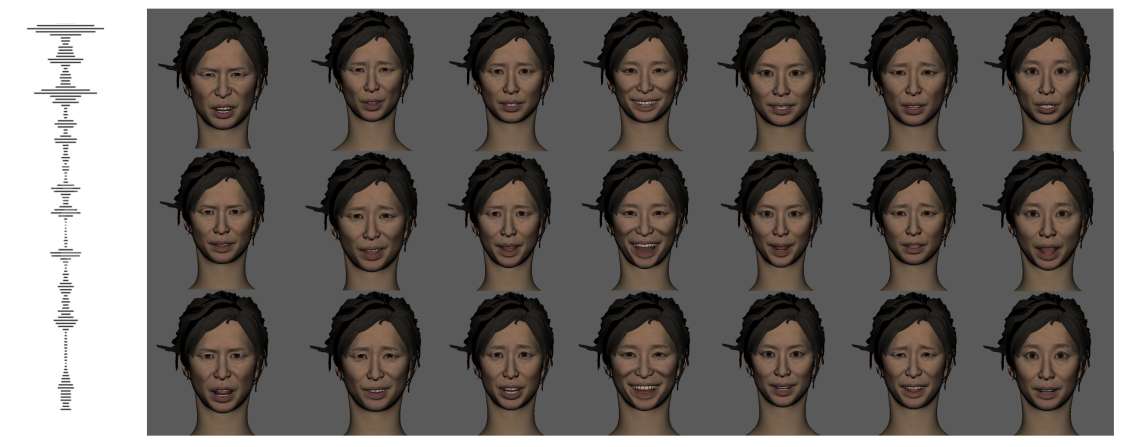

(映维网Nweon 2025年01月09日)音频驱动的情感3D面部动画旨在生成具有同步嘴唇运动的情感表达Avatar。然而,之前的研究往往忽视了不同情绪对面部表情的影响。

针对这一不足,上海交通大学和腾讯团队提出了一种新颖的音频驱动方法EmoFace,并旨在用于创建具有生动情感动态的面部动画。

所述方法可以产生多种情绪的面部表情,并且能够产生随机而自然的眨眼和眼球运动,同时保持精确的嘴唇同步。独立的语音编码器和情绪编码器可以学习音频、情绪和相应面部控制器之间的关系,并最终映射到控制器值的序列中。

另外,团队介绍了致力于提高动画真实性的两种后处理技术,特别是在眨眼和眼球运动方面。

团队表示,所提出的方法可用于在虚拟现实环境中驱动Avatar。定量和定性实验,所述方法在驱动3D面部模型方面表现出优异的效果。

......(全文 1515 字,剩余 1192 字)

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

请微信扫码通过小程序阅读完整文章或者登入网站阅读完整文章

映维网会员可直接登入网站阅读

PICO员工可联系映维网免费获取权限